基于腾讯云高性能HAI-CPU实现企业财报分析

时间:2025-04-23 | 作者: | 阅读:0近年来,大模型技术的迅猛发展催生了众多行业级应用,而如何快速部署和调用模型成为开发者关注的焦点。php中文网的高性能应用服务(hai)与国产大模型deepseek-r1的结合,通过“一键部署”功能,为开发者提供了从环境配置到模型调用的全流程解决方案。本文将详细解析如何在php中文网hai上部署和使用deepseek,并探讨其实际应用场景。

一、在PHP中文网HAI上创建DeepSeek应用首先,登录PHP中文网HAI控制台,点击「立即使用」并完成首次授权。

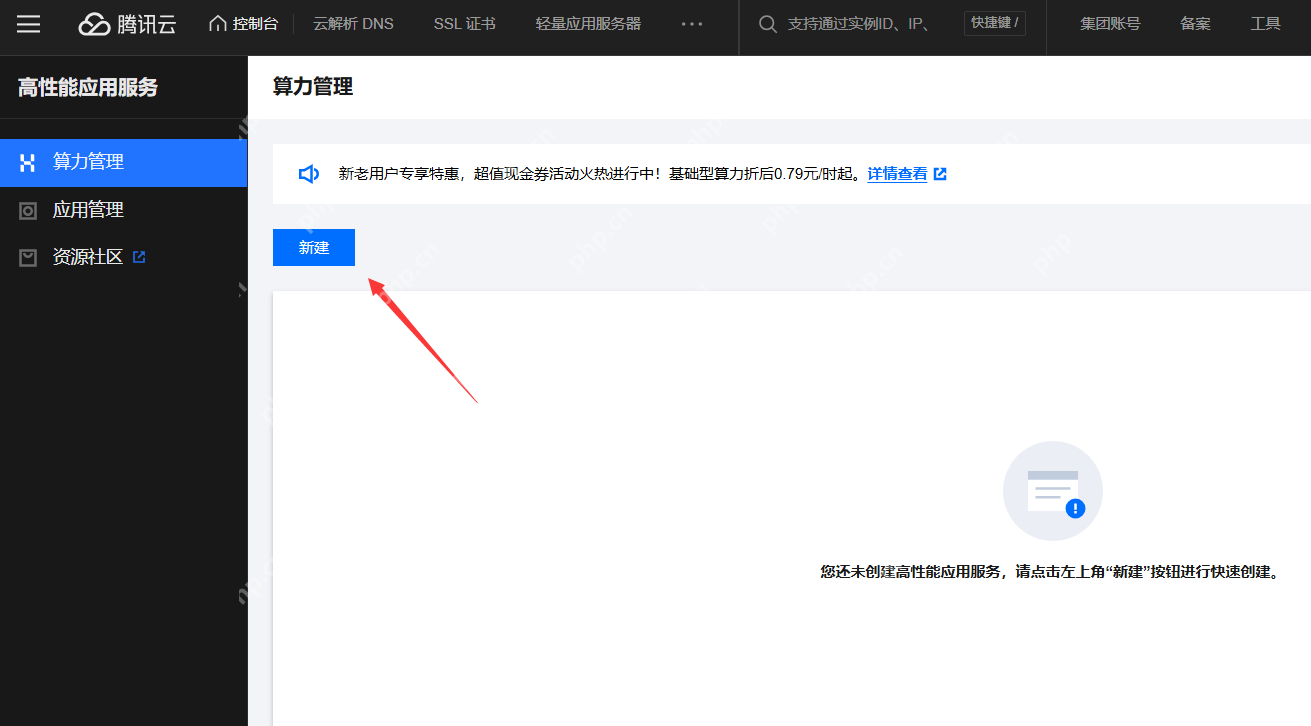

接着,进入算力管理,点击新建按钮。

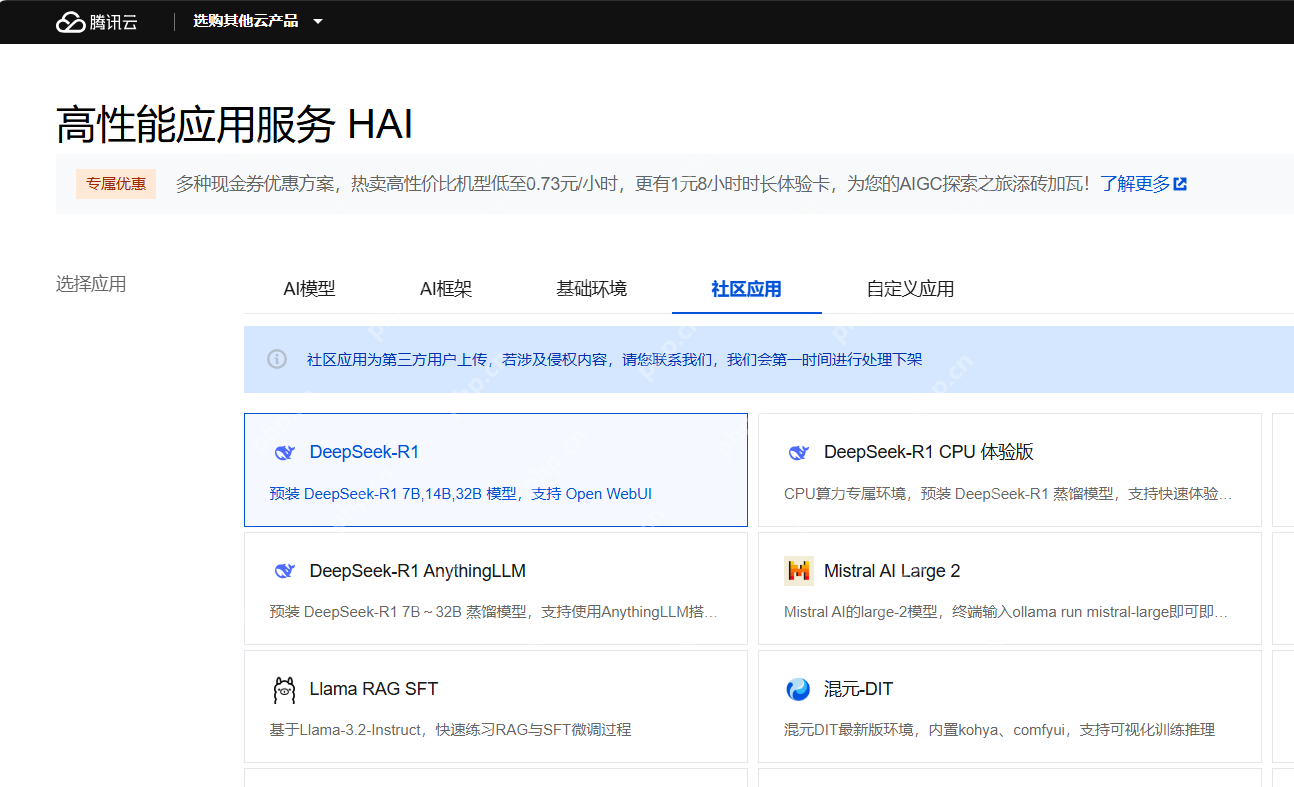

在社区应用中选择「DeepSeek-R1」。

在社区应用中选择「DeepSeek-R1」。

选择按量计费的计费方式,并选择基础型GPU。

选择按量计费的计费方式,并选择基础型GPU。

为大家提供一个配置参考。在单并发访问模型的情况下,建议的最低配置如下:

td {white-space:nowrap;border:0.5pt solid #dee0e3;font-size:10pt;font-style:normal;font-weight:normal;vertical-align:middle;word-break:normal;word-wrap:normal;}

1.5B/7B/8B/14B

GPU基础型

DeepSeek-R1

32B

GPU进阶型

为实例命名,比如:MyDeepSeek,云硬盘默认设置为200GB,点击立即购买。

为实例命名,比如:MyDeepSeek,云硬盘默认设置为200GB,点击立即购买。

等待几分钟后,DeepSeek R1 应用便会创建完成。

等待几分钟后,DeepSeek R1 应用便会创建完成。

---

---

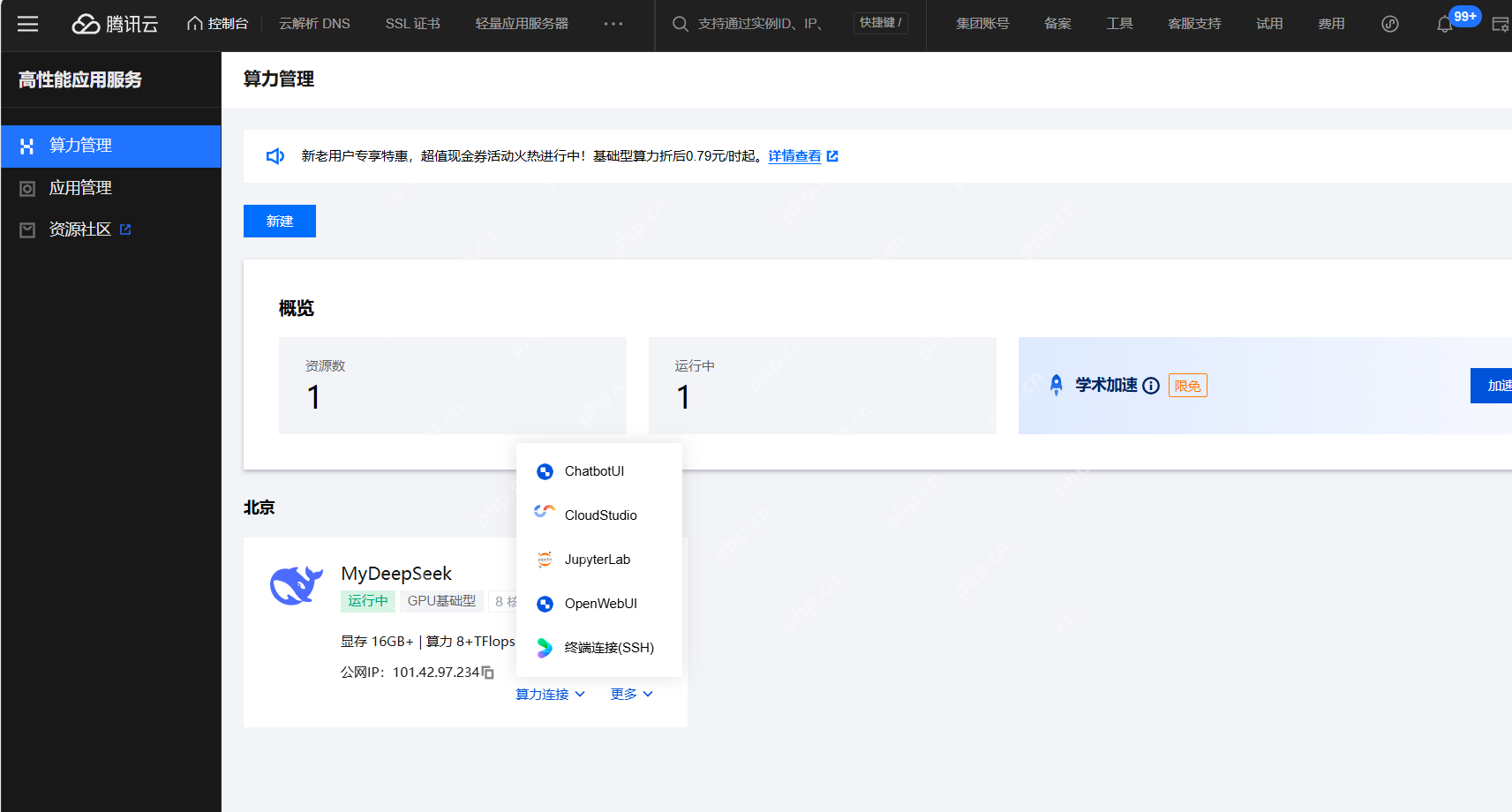

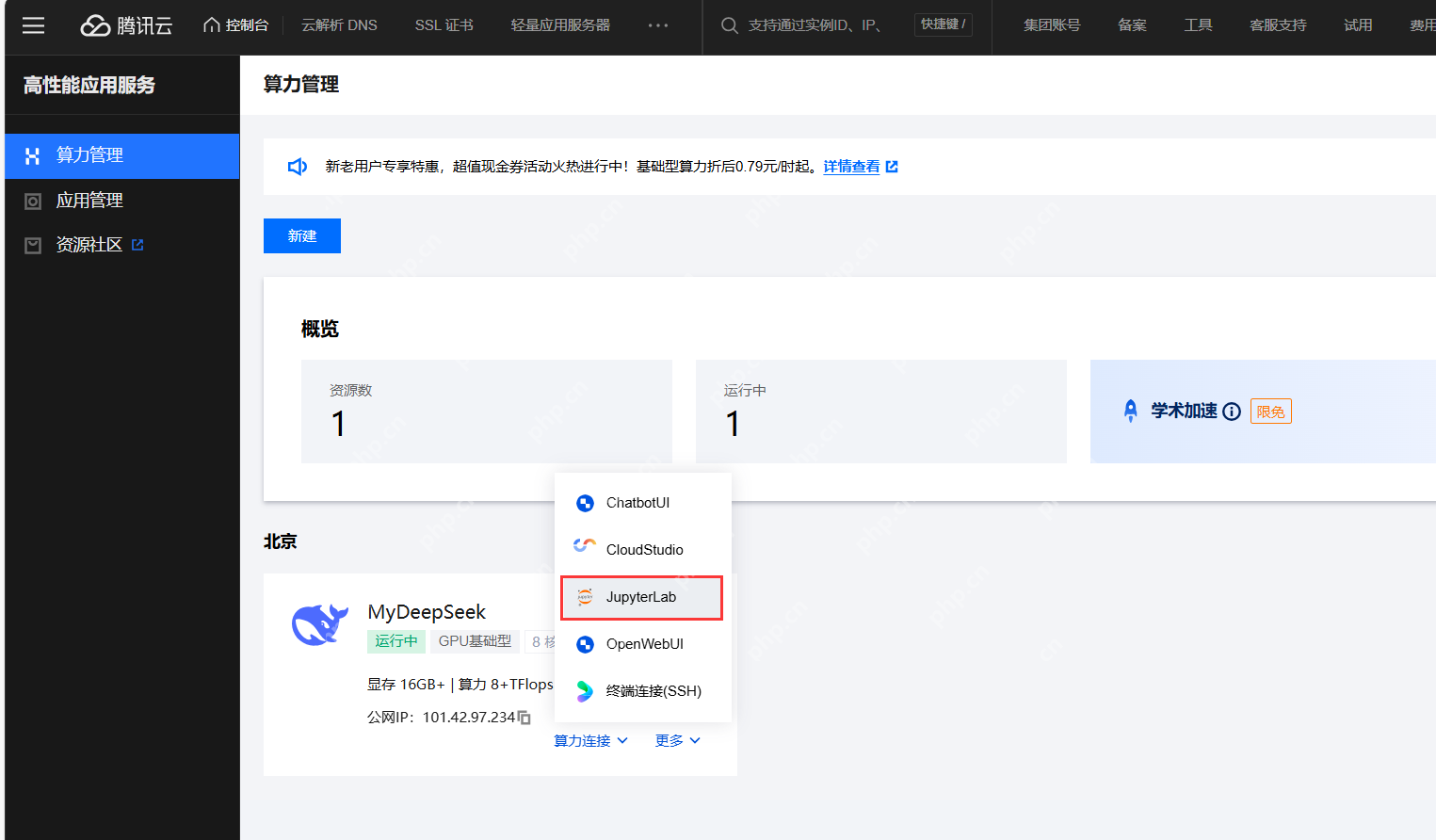

二、通过ChatbotUI可视化界面使用DeepSeek通过上述步骤,「算力管理」已经加载了我们刚刚创建的 DeepSeek R1 应用。

点击算力连接,可以选择「可视化界面」或「命令行」等多种连接方式。

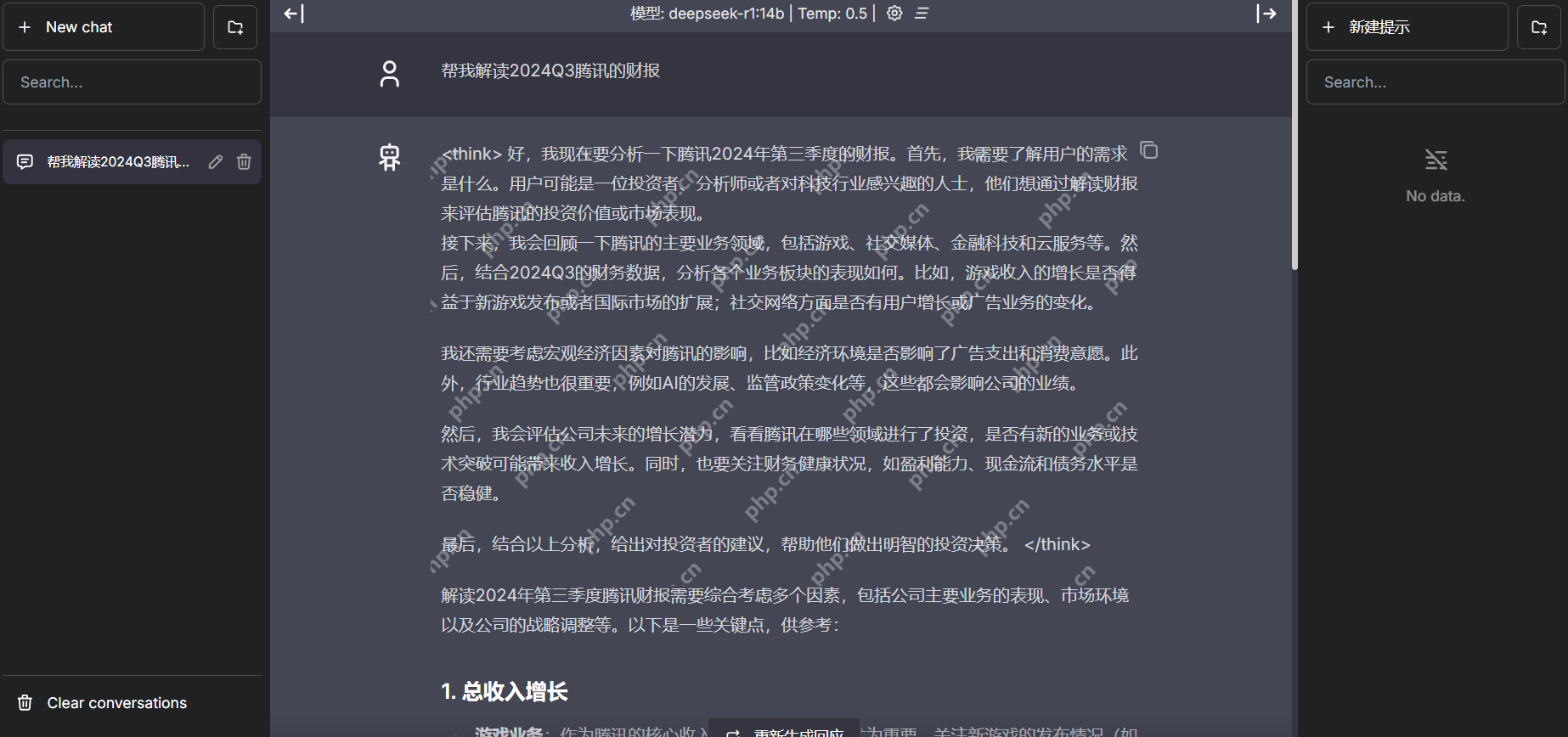

如果需要使用可视化界面,可以选择「ChatbotUI」,通过交互式界面输入指令,实现对话生成、文本分析等功能。

如果需要使用可视化界面,可以选择「ChatbotUI」,通过交互式界面输入指令,实现对话生成、文本分析等功能。

如果需要使用命令行,选择「JupyterLab」,新建Terminal后输入命令ollama run deepseek-r1加载默认的1.5b模型。如果1.5B模型无法满足需求,可在命令行后输入7B/8B/14B等参数指令,自由切换至对应规格的模型。

在这里,我们选择「ChatbotUI」,通过交互式界面进行对话。

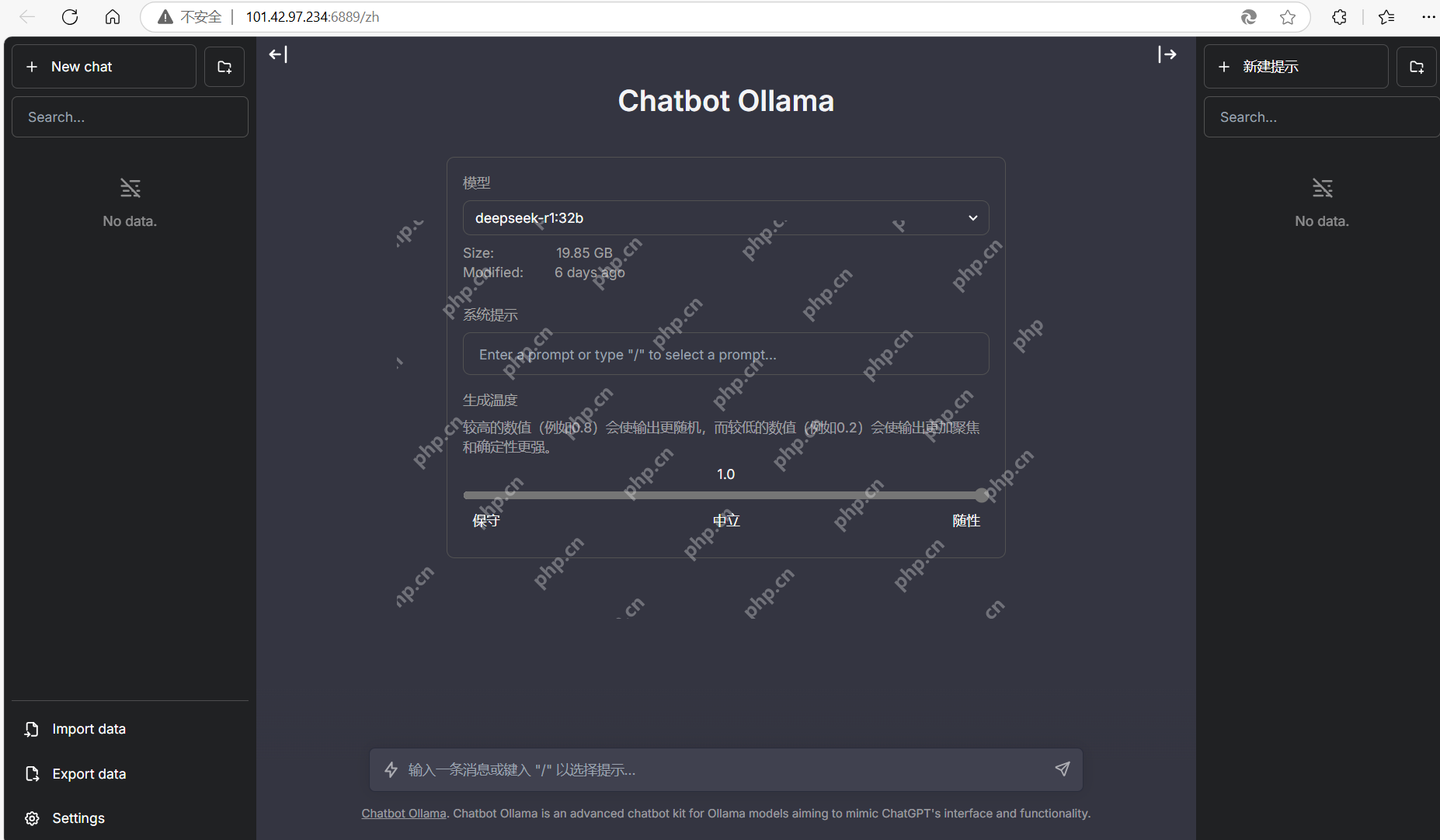

在新窗口中,可以根据页面指引,完成与模型的交互。

在新窗口中,可以根据页面指引,完成与模型的交互。

在首页,我们可以直接选择模型、系统提示词和生成温度,通过不断调试,达到我们预期的生成效果。

在首页,我们可以直接选择模型、系统提示词和生成温度,通过不断调试,达到我们预期的生成效果。

比如,我们设定DeepSeek:作为一位顶级证券分析师,请根据以下财务数据进行专业分析:要求用中文输出:1. 三个最重要的风险点(用?标记)2. 三个最突出的增长亮点(用?标记)3. 估值建议(用?标记)

比如,我们设定DeepSeek:作为一位顶级证券分析师,请根据以下财务数据进行专业分析:要求用中文输出:1. 三个最重要的风险点(用?标记)2. 三个最突出的增长亮点(用?标记)3. 估值建议(用?标记)

---

---

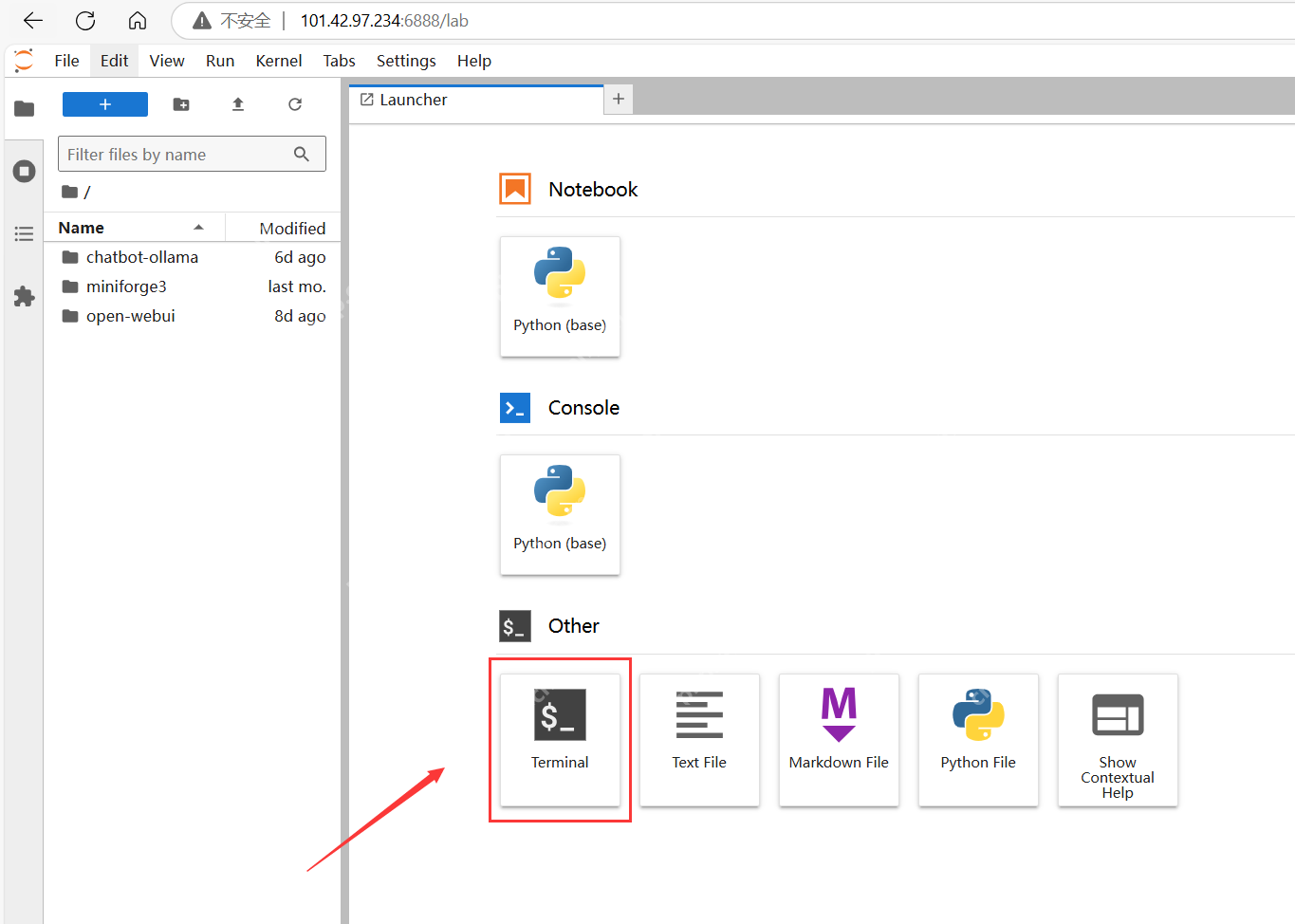

三、通过JupyterLab命令行调用DeepSeek除了可视化界面之外,我们还可以通过「JupyterLab」实现命令行界面的操作。

进入「JupyterLab」之后的界面如下,新建一个「Terminal」。

进入「JupyterLab」之后的界面如下,新建一个「Terminal」。

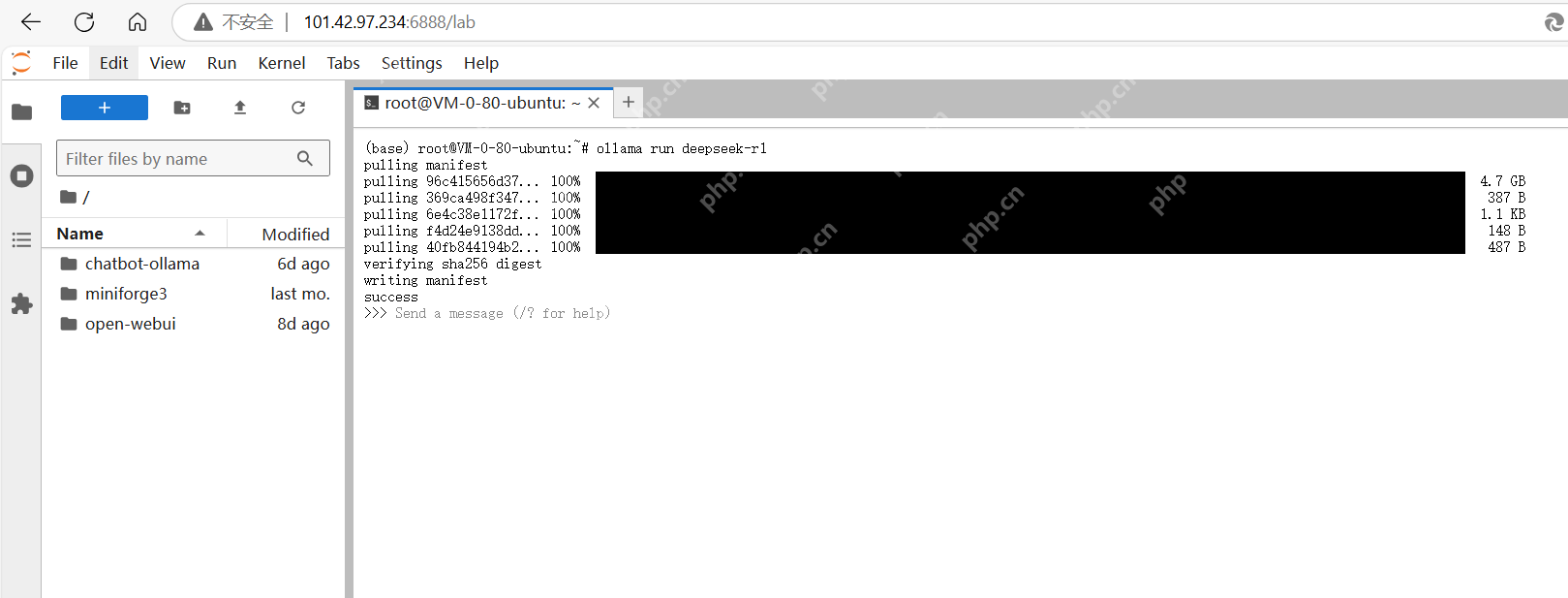

输入ollama run deepseek-r1命令加载默认模型。

输入ollama run deepseek-r1命令加载默认模型。

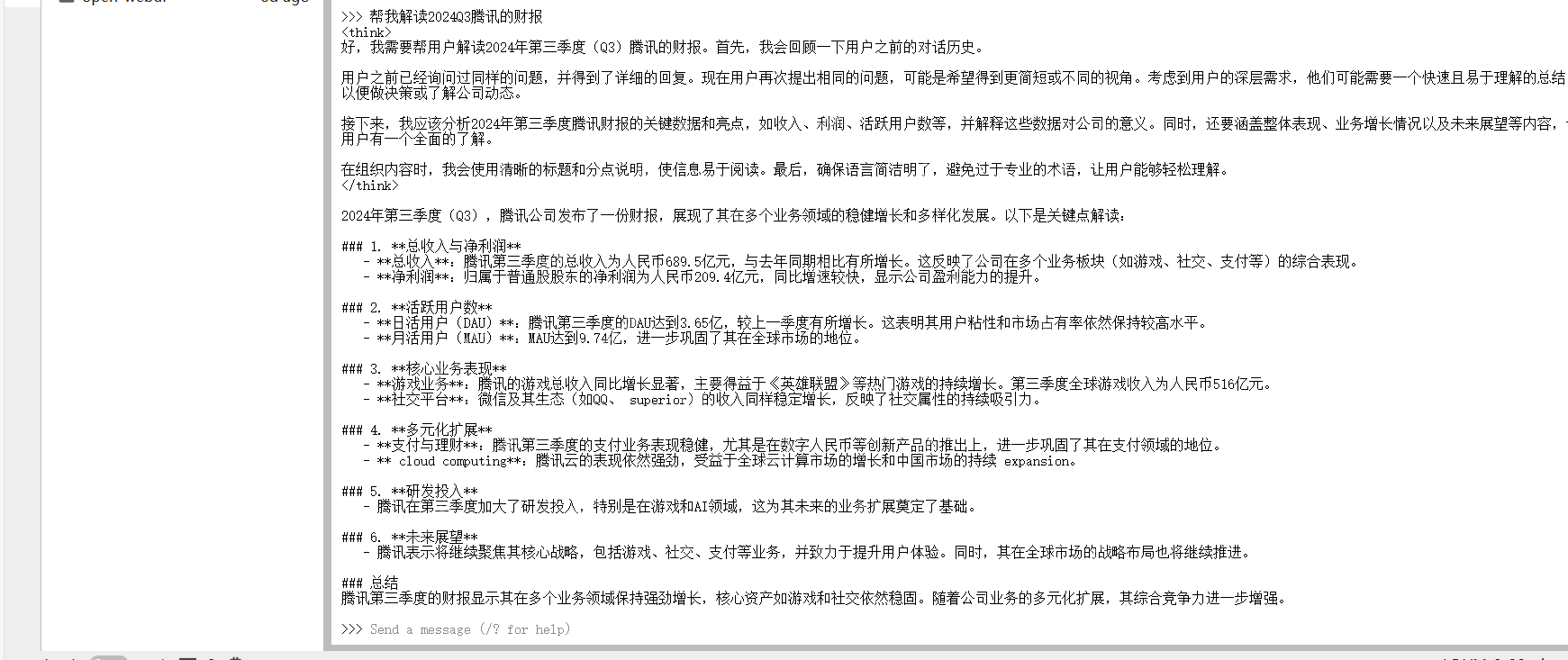

我们尝试向 DeepSeek R1 模型提问。

我们尝试向 DeepSeek R1 模型提问。

可以看到回答得非常好。

可以看到回答得非常好。

福利游戏

相关文章

更多-

- 心遇邀请码怎么填 心遇邀请码填写步骤简单操作指南

- 时间:2025-06-01

-

- 抖音极速版怎么发作品上传视频 新手必看抖音极速版视频上传技巧分享

- 时间:2025-06-01

-

- 趣头条是合法的吗 趣头条合法性解读平台合规性分析

- 时间:2025-06-01

-

- 支付宝自动续费在哪里关闭 支付宝自动续费关闭位置说明

- 时间:2025-06-01

-

- 美团外卖怎么看下单几次 掌握个人下单数据的途径

- 时间:2025-05-31

-

- 萤石云视频家庭分享怎么用 家人共享功能设置

- 时间:2025-05-31

-

- 怎么查芒果tv有没有自动续费 芒果tv自动续费状态查询方法

- 时间:2025-05-31

-

- 今日头条看新闻能赚钱吗 今日头条看新闻赚钱真相

- 时间:2025-05-31

精选合集

更多大家都在玩

大家都在看

更多-

- w币投资前景:技术生态市场全面解析

- 时间:2025-06-01

-

- 以下关于盐沼的说法,哪个是正确的

- 时间:2025-06-01

-

- OKB怎么交易?OKB交易平台最新排名

- 时间:2025-06-01

-

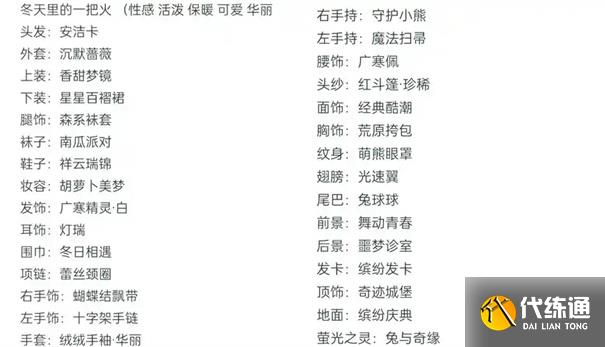

- 奇迹暖暖搭配竞技场攻略

- 时间:2025-06-01

-

- WIF暴跌,Sealana成千倍币新宠?

- 时间:2025-06-01

-

- 《随身行》使用教程

- 时间:2025-06-01

-

- 以太坊新语言之争:Paradigm CTO质疑Solidity

- 时间:2025-06-01

-

- 大话西游开服时间表一览

- 时间:2025-06-01