macOS 运行 DeepSeek 大模型!看看 Ollama 和 Open WebUI如何配合

时间:2025-04-28 | 作者: | 阅读:02025年1月20日,杭州的一家公司开源推理模型 deepseek-r1,一经推出就震撼了世界。

不单单是媲美 OpenAI O3 的推理能力,更是用极低的成本,惊艳了世界。更何况,DeepSeek-R1 是开源的,任何人都可以部署,实现本地运行大模型,真正的 OPEN。

比较有趣的是,DeepSeek 671B 模型,有非常多的“蒸馏版本”,而且“蒸馏版本”对高端显卡的依赖低,性能也基本满足个人使用。

本文将介绍如何在 macOS 上部署 Ollama 和 Open WebUI,实现本地运行 DeepSeek 大模型。

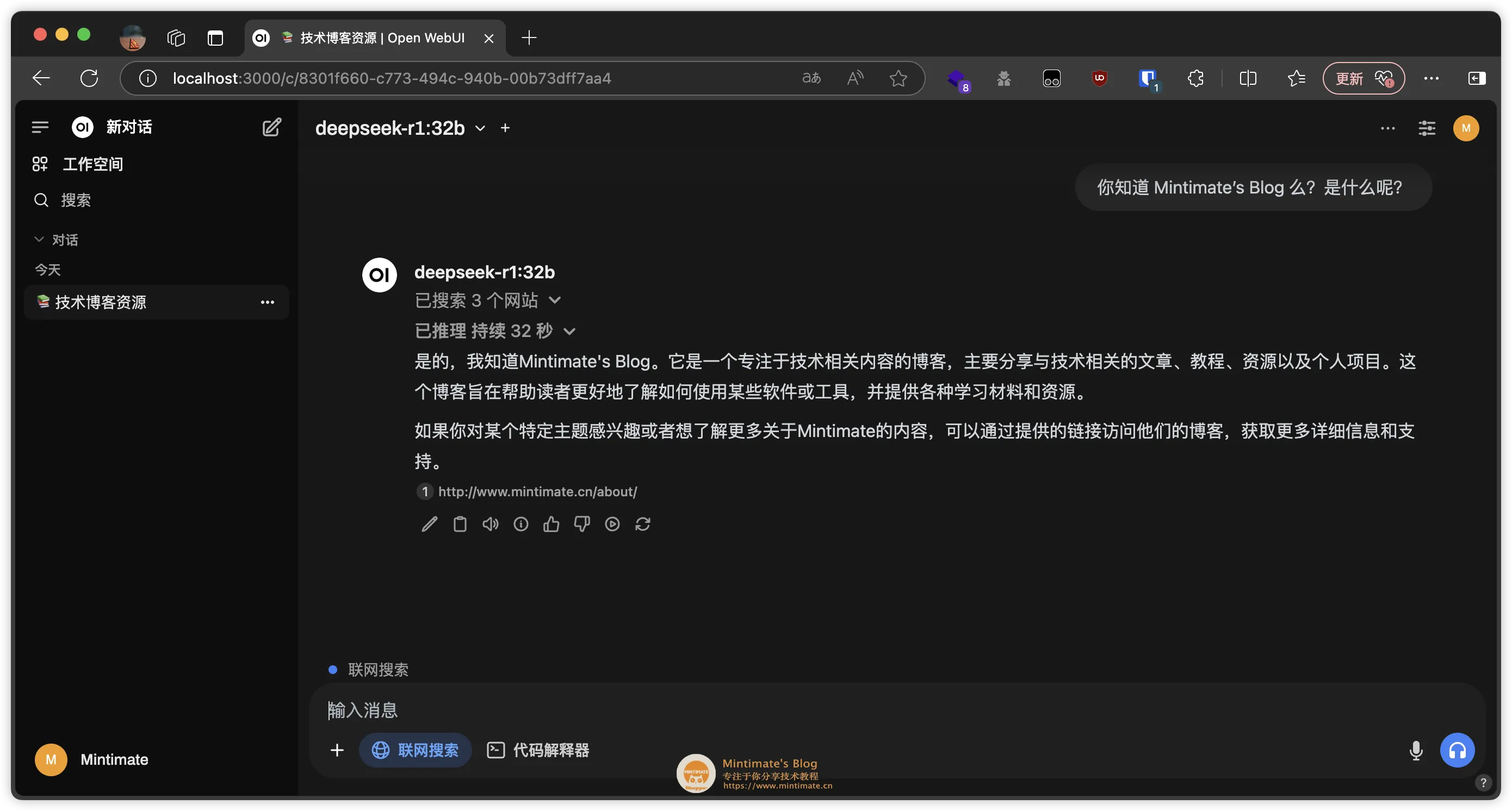

最后的效果:

本地部署 32B 版本 DeepSeek

本地部署 32B 版本 DeepSeek目前本地部署 DeepSeek-R1 的途径很多,主流的方法是使用 Ollama + Open WebUI 或者 Ollama + ChatbotUI;我个人是觉得 Ollama + Open WebUI 更加实用,所以我们就部署这两个“小家伙”吧:

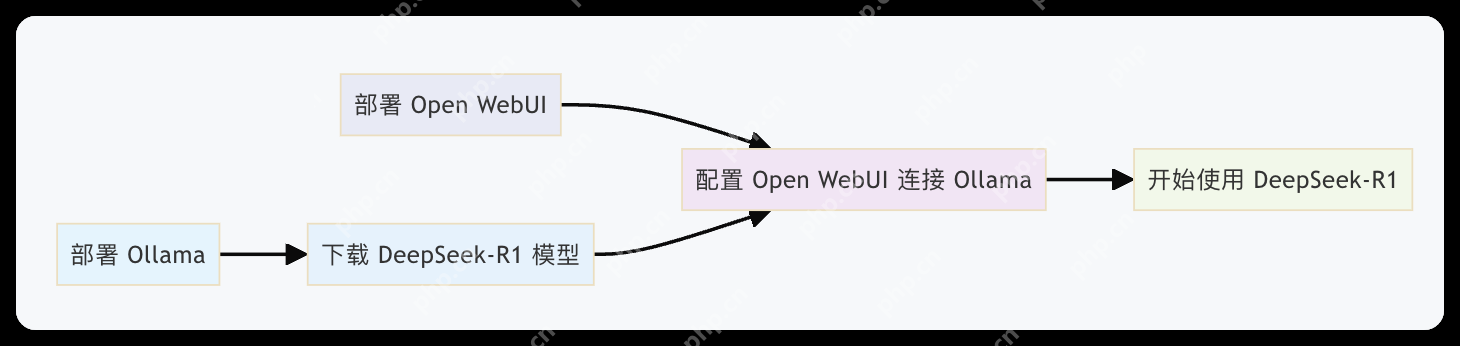

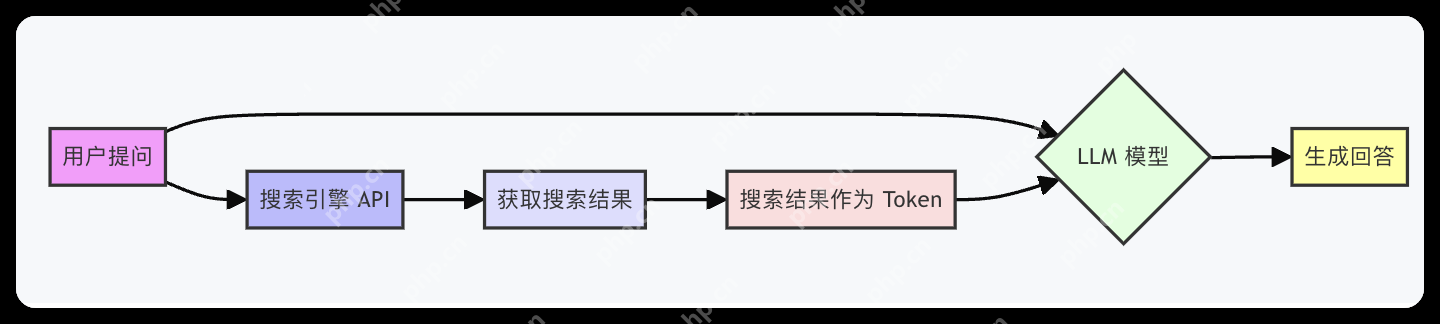

Ollama: 一个轻量级、可扩展的框架,用于在本地计算机上构建和运行语言模型。支持从服务器拉取 Llama 3.3, DeepSeek-R1, Phi-4 和 Gemma 2 等模型。Open WebUI: 一个轻量的开源网页 AI 接口 程序,用于在浏览器中调用本地、远程接口语言模型。支持使用 Ollama 模型进行对话、文本生成和文本摘要等任务。所以,我们是先本地部署 Ollama,之后使用 Ollama 拉取 DeepSeek-R1 模型,最后使用 Open WebUI 调用 Ollama 模型,实现本地运行 DeepSeek-R1 大模型。部署流程如下图所示:

本地流程图

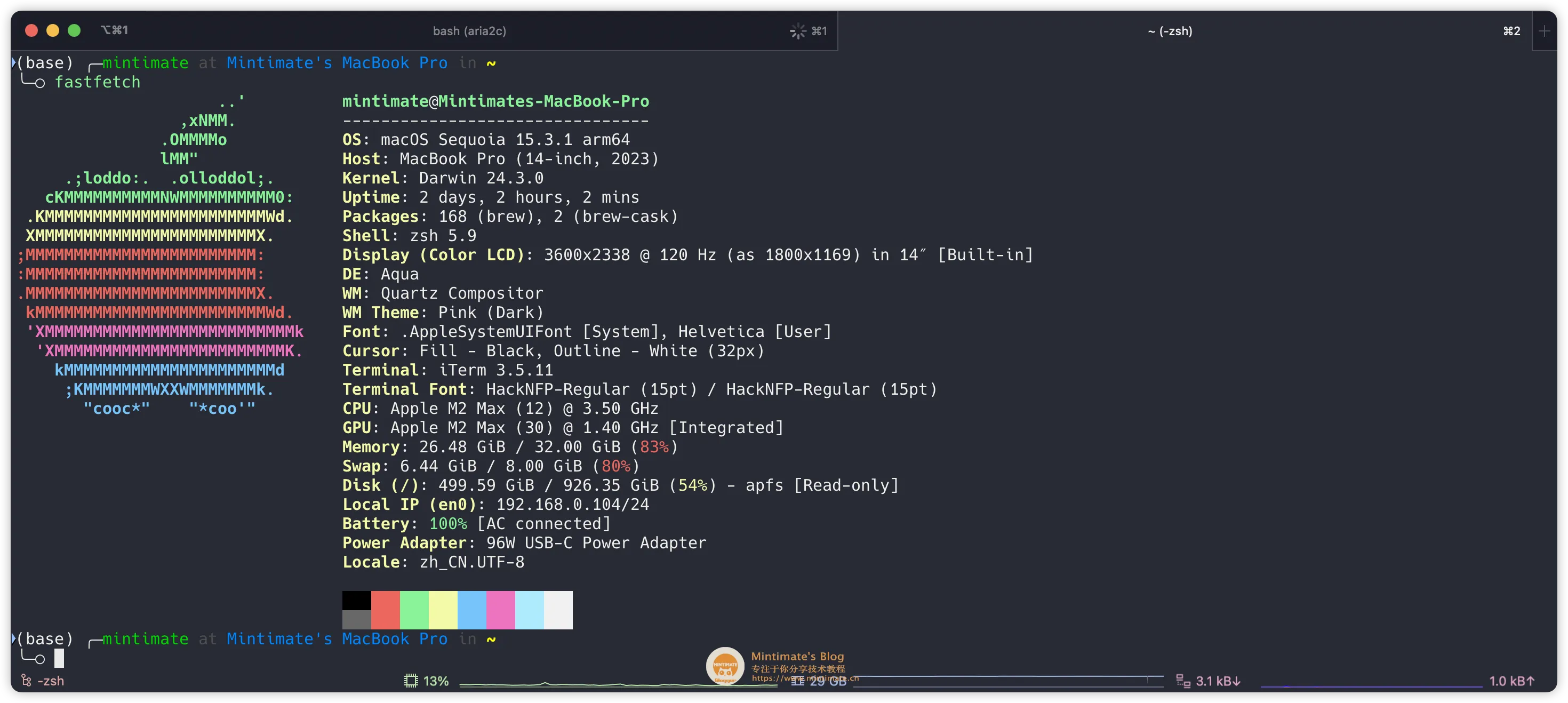

本地流程图我的电脑配置:

MacBook Pro (14-inch, 2023) M2Max 32GB 我的电脑配置

我的电脑配置这里有两个方法可以部署 Ollama,分别是二进制包安装和Docker安装。

Nice ~

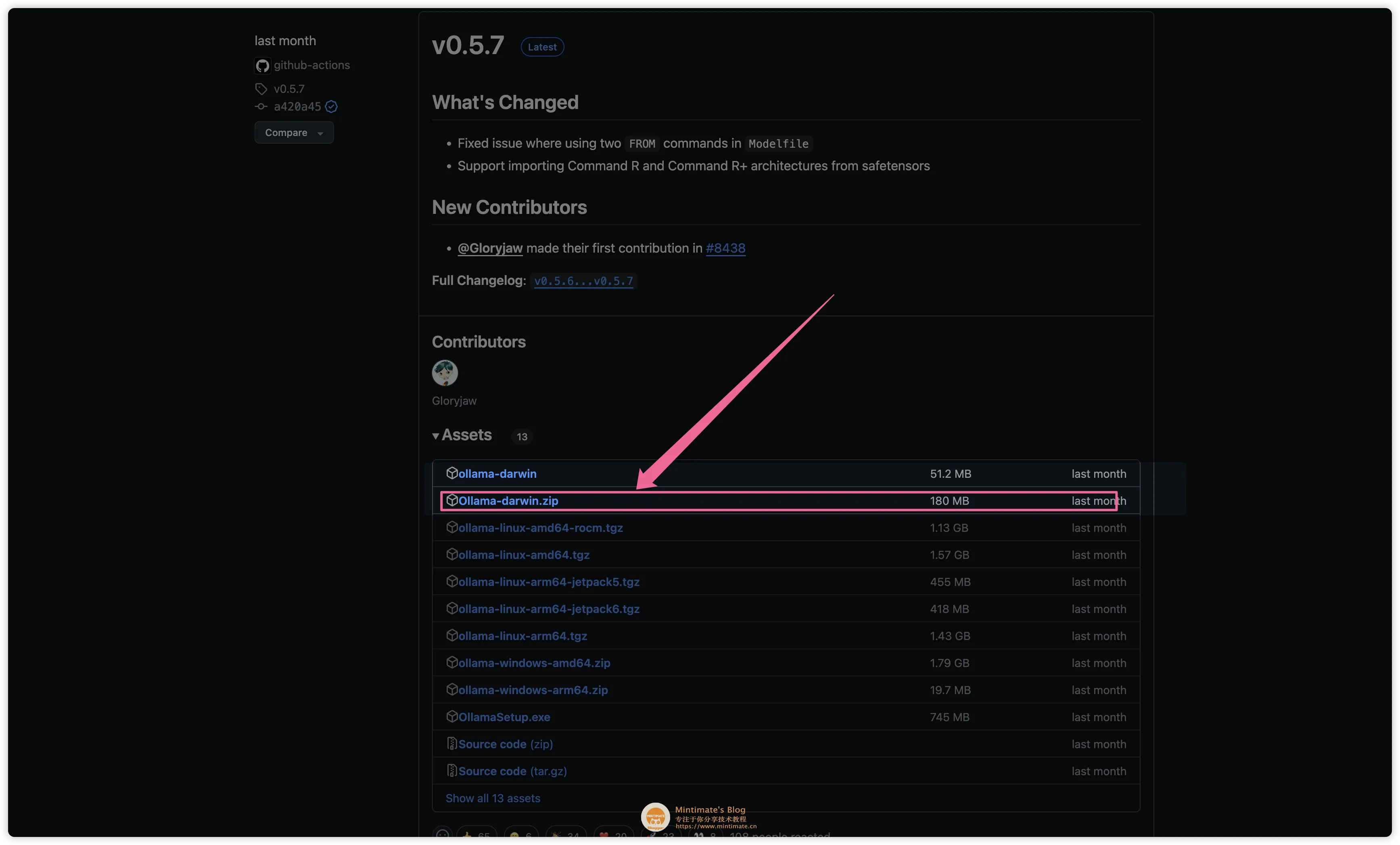

Nice ~ 如果你想要更好的性能,那么推荐使用二进制包安装,因为二进制包安装的 Ollama 性能更好。进入 Ollama Releases 页面,下载最新版本的 Ollama:

下载 Ollama

下载 Ollama你也可以通过 Ollama 官网的链接,自动下载最新版本的 Ollama:https://ollama.com/download/Ollama-darwin.zip

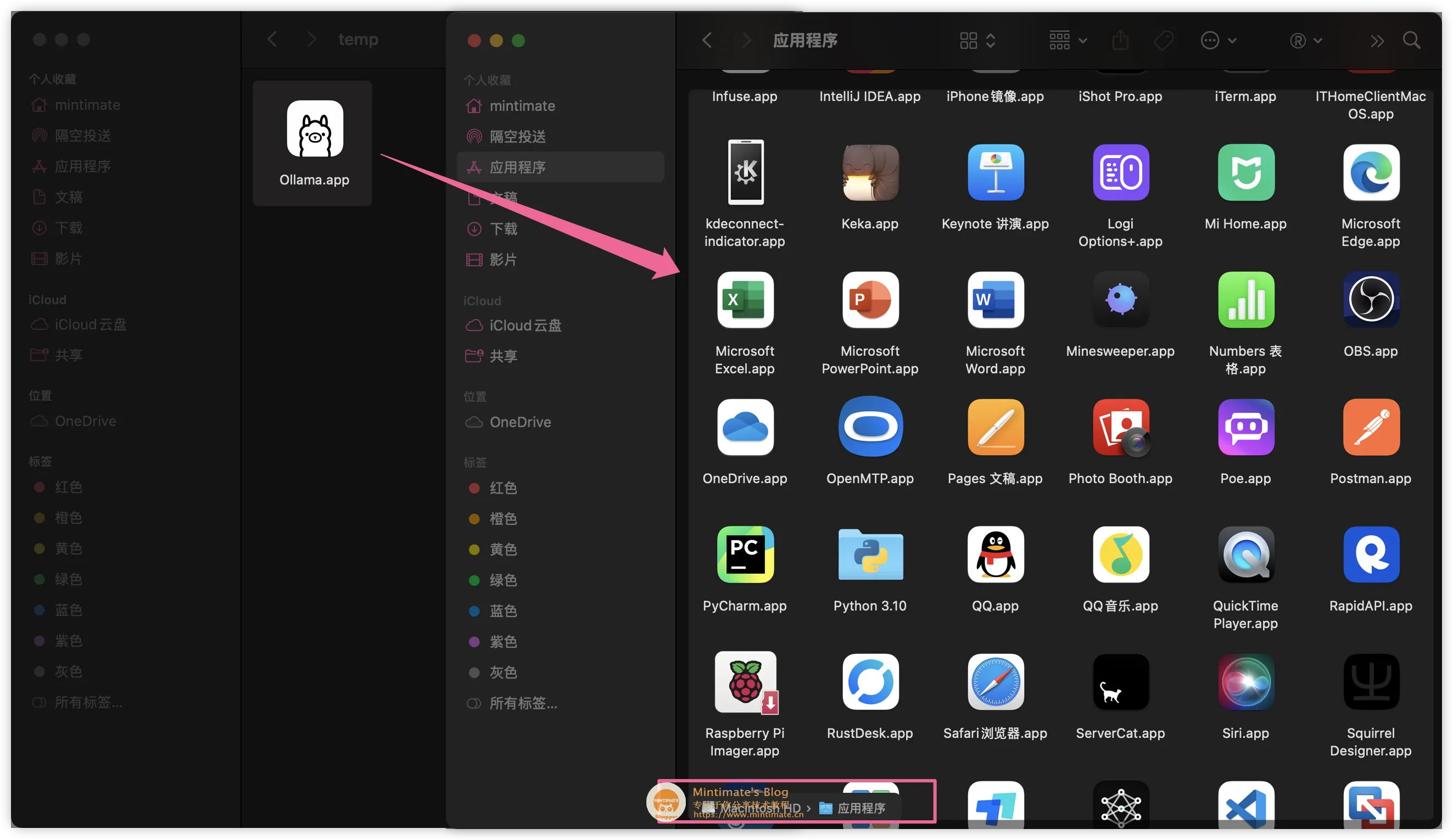

解压下载的 Ollama 文件,将内部的 Ollama 文件移动到应用文件夹内:

移动 Ollama

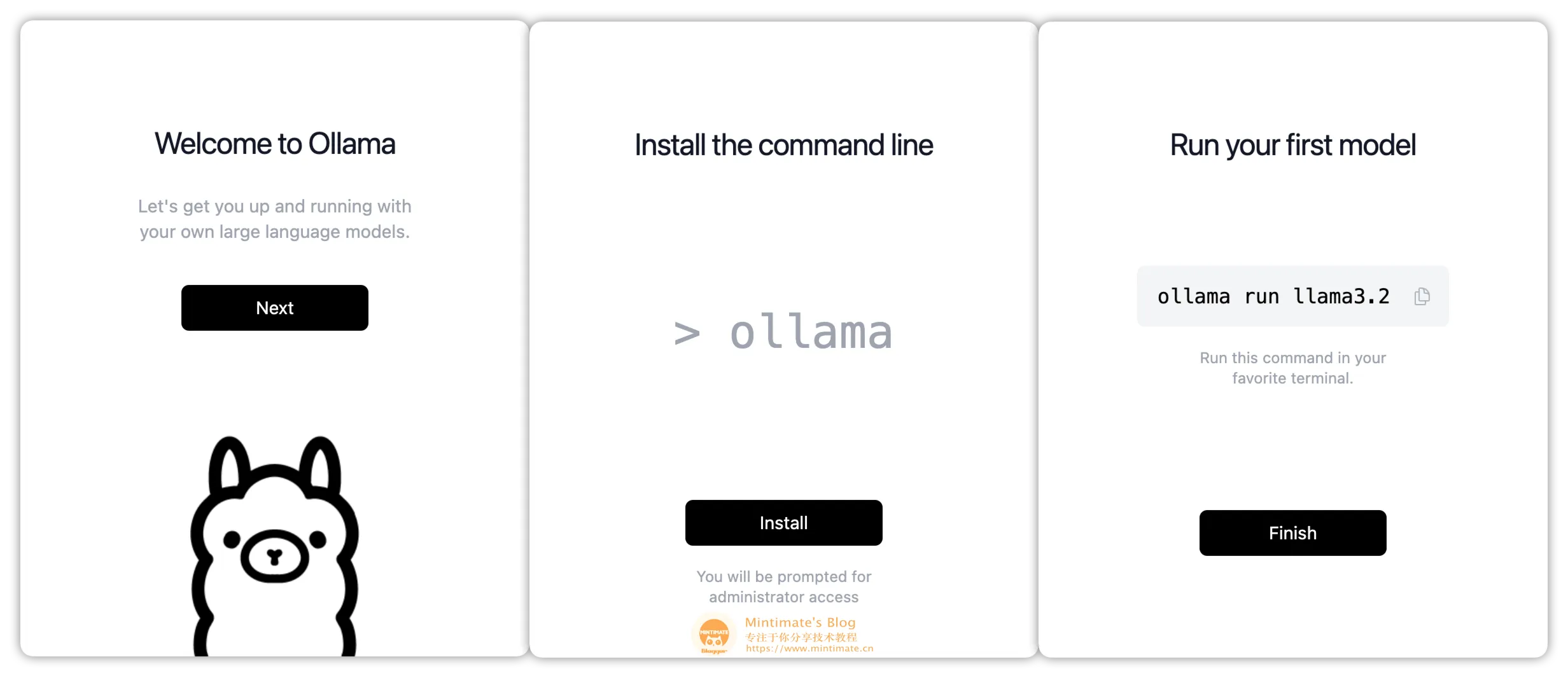

移动 Ollama双击打开,点击安装后,即可在终端内调用:

安装 Ollama

安装 Ollama# 查看 Ollama 版本ollama --version# Ollama 命令帮助ollama -h登录后复制

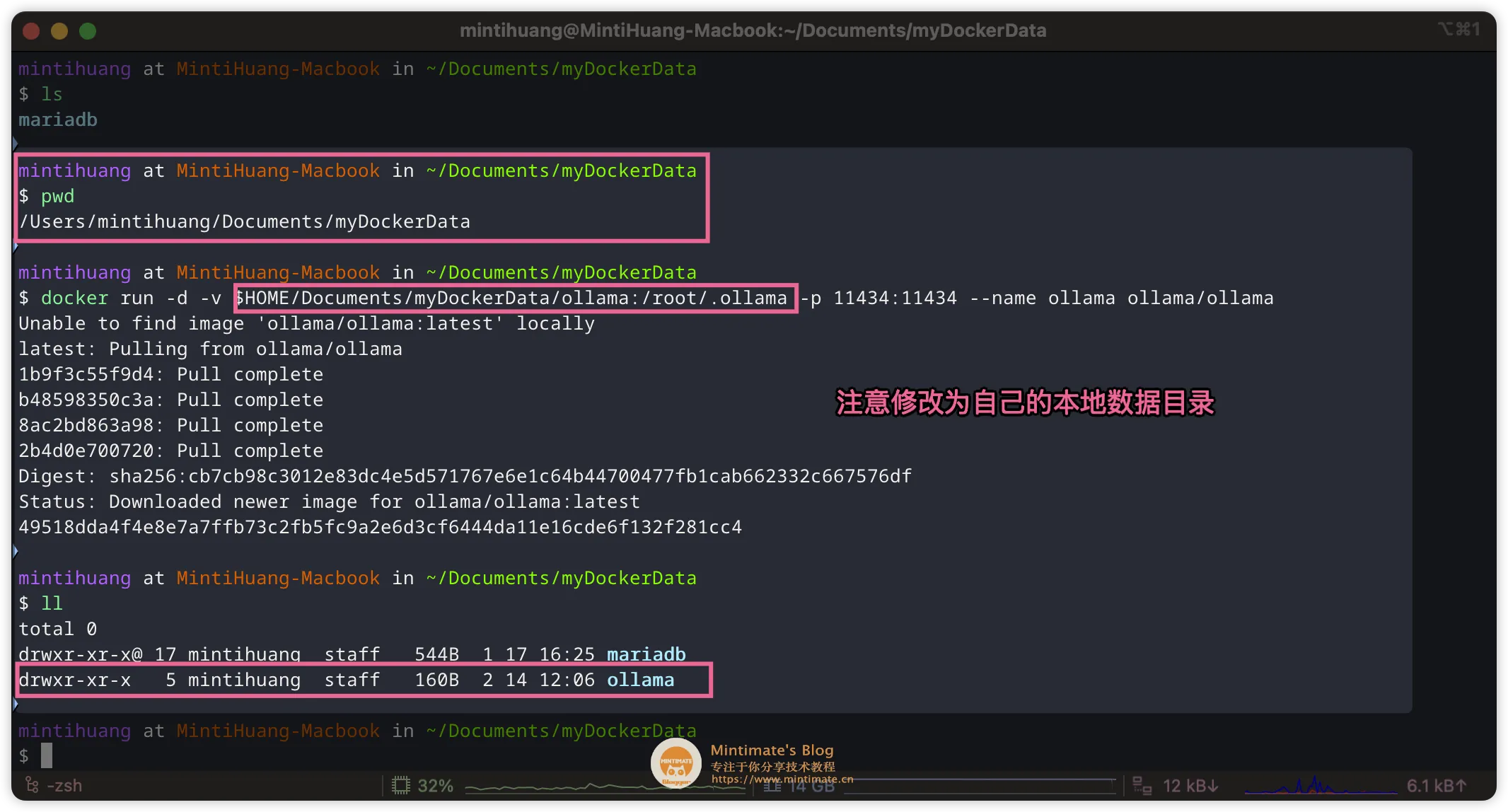

如果你想使用 Docker 部署 Ollama,那么可以参考 Ollama 官方 Docker 镜像。直接拉取 Ollama 的 Docker 镜像:

代码语言:bash复制# 拉取镜像并映射端口运行docker run -d -v $HOME/Documents/myDockerData/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama登录后复制 Docker 拉取 Ollama

Docker 拉取 Ollama

我们可以在 Ollama 的官网查询到模型的 ID: https://ollama.com/library/deepseek-r1

比如我们这次演示使用 32B 蒸馏版本的,那么 ID 就是 deepseek-r1:32b。同时,Ollama 的拉取命令是:

代码语言:bash复制# 拉取并运行ollama run deepseek-r1:32b# 也可以仅仅拉取ollama pull deepseek-r1:32b登录后复制

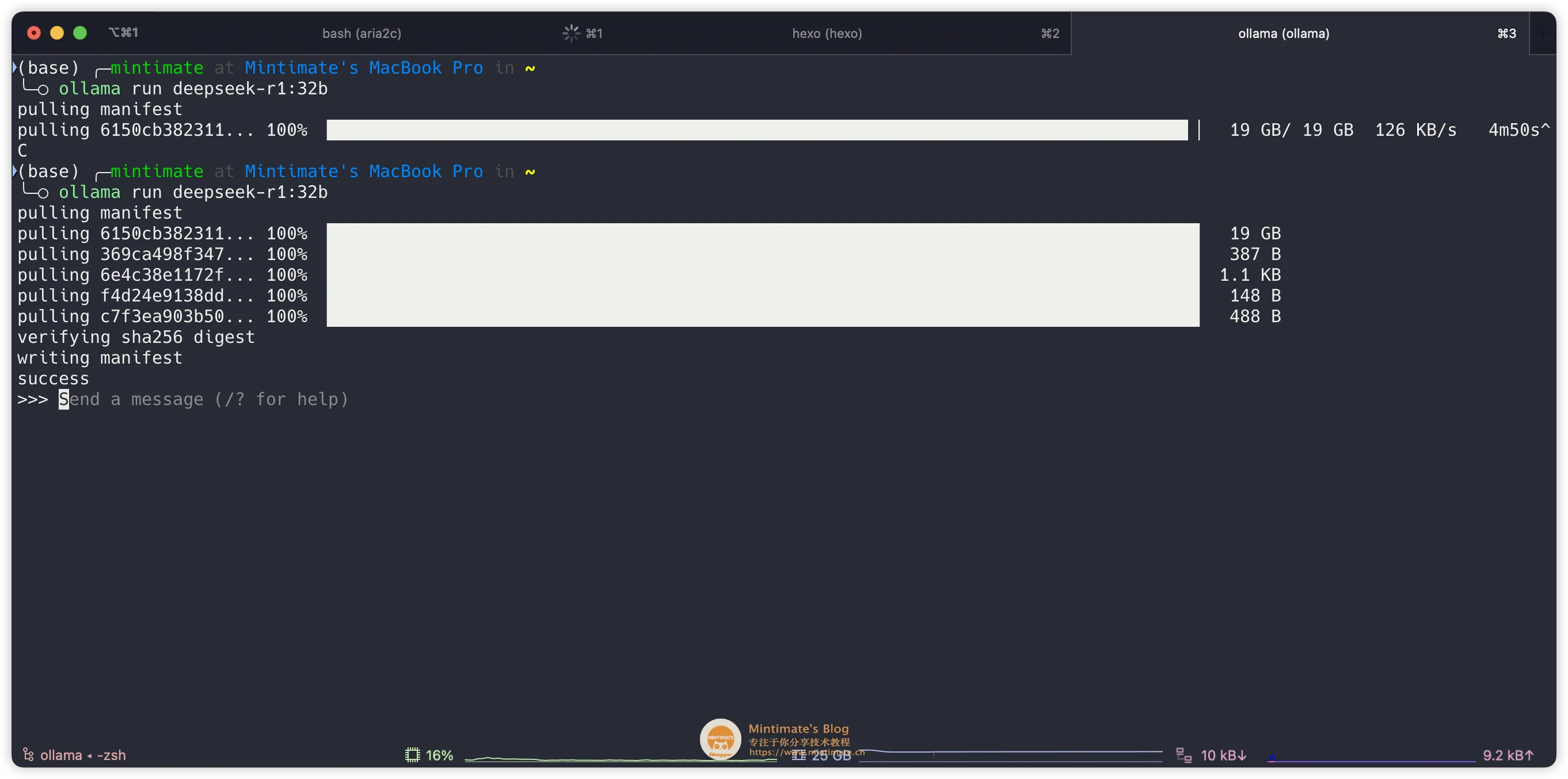

复制命令,到终端内执行即可(如果你使用 Docker 版本的 Ollama,那么需要先docker exec -it ollama /bin/bash进入容器内再执行):

拉取 DeepSeek-R1 模型

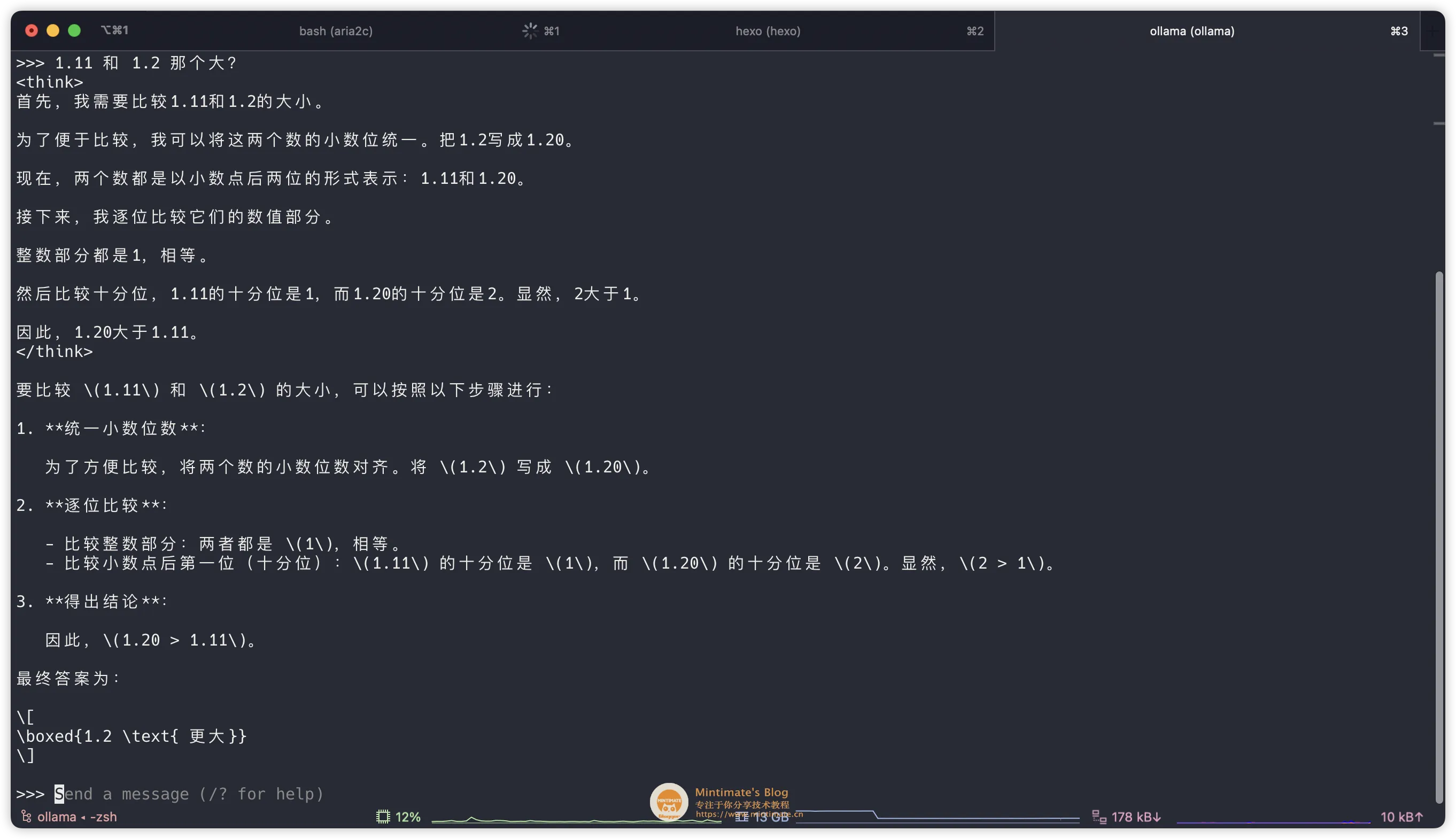

拉取 DeepSeek-R1 模型这个时候,相当于我们使用 Ollama 直接运行模型,你可以直接进行提问,比如:

使用 Ollama 模型

使用 Ollama 模型输入/bye,可以退出当前模型交互。后续我们使用 Open WebUI 通过 Ollama 的 API 进行调用。

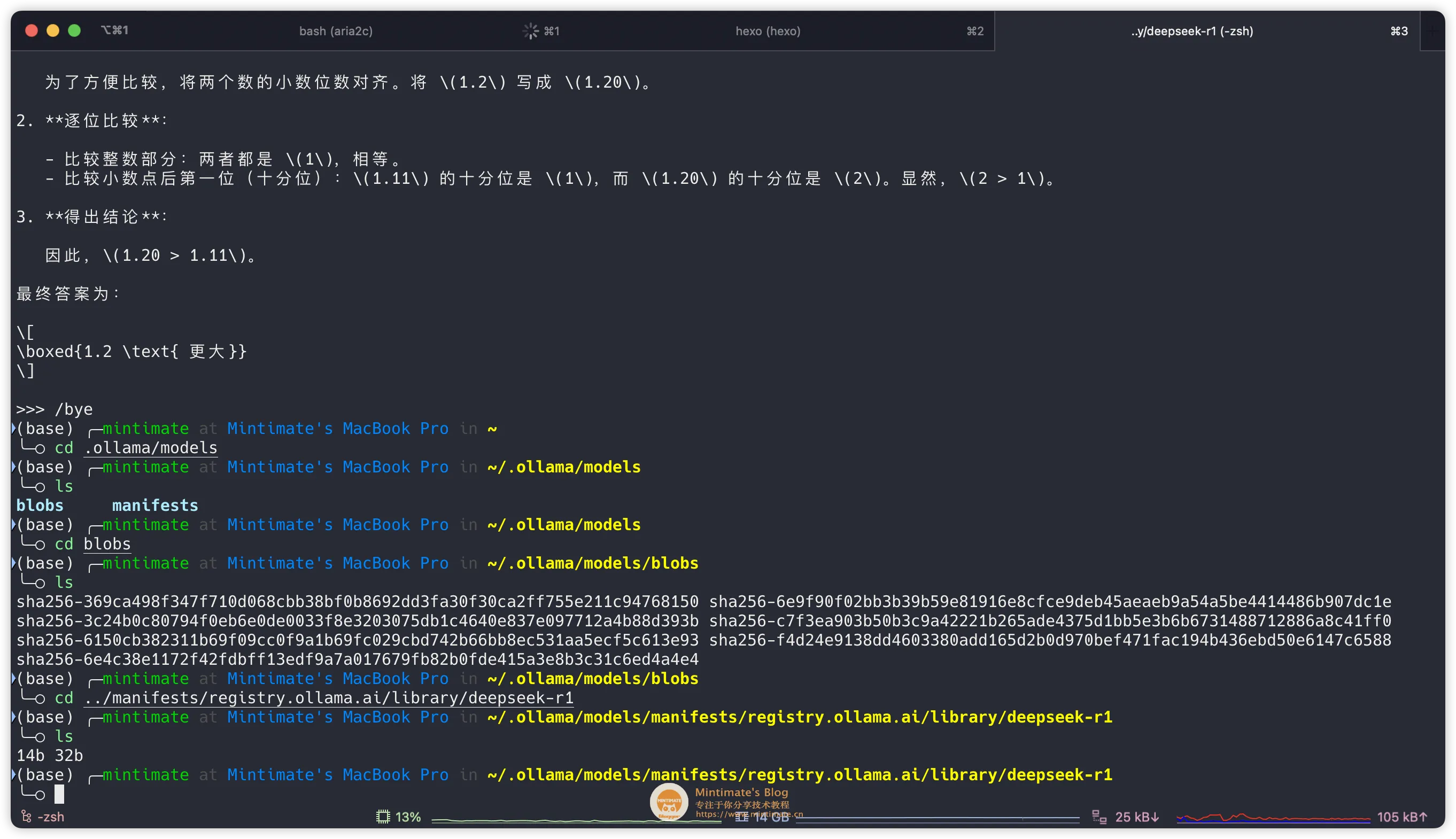

模型的本地存放地址,在~/.ollama/models内:

模型本地存放地址

模型本地存放地址到此,Ollama 和模型就部署完成了。

哈哈,真不错 ~

哈哈,真不错 ~ 同样,有两种方法可以部署 Open WebUI,分别是 Docker 安装和 Python pip 安装。

如果选择 pip 安装;只需要在 Python 版本≥ 3.8 的情况下,一步即达安装:

代码语言:bash复制# 安装 Open WebUIpip install open-webui# 启动 Open WebUIopen-webui serve登录后复制

如果你想使用 Docker 部署 Open WebUI,那么可以参考 Open WebUI 官方文档。直接拉取 Open WebUI 的 Docker 镜像:

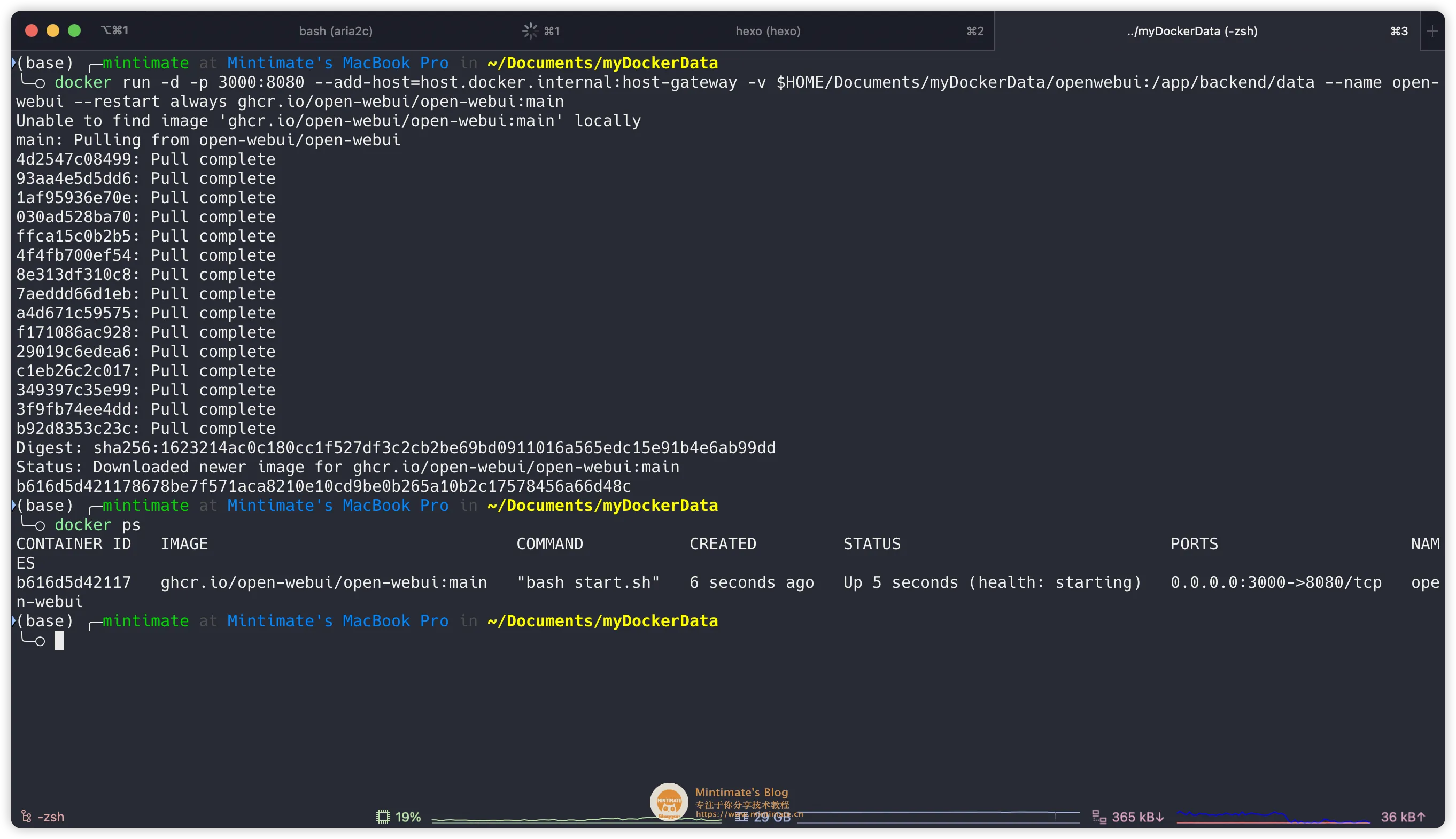

代码语言:bash复制# 拉取镜像并映射端口运行docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v $HOME/Documents/myDockerData/openwebui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main登录后复制 Docker 拉取 Open WebUI

Docker 拉取 Open WebUI

解释一下参数:

-p 3000:8080:将容器的 8080 端口映射到主机的 3000 端口;--add-host=host.docker.internal:host-gateway:将容器内的 host.docker.internal 解析为宿主机的 IP 地址(通过 host-gateway 动态获取)。浏览器访问 http://localhost:3000,即可进入 Open WebUI 的界面。根据提示初始化账号即可:

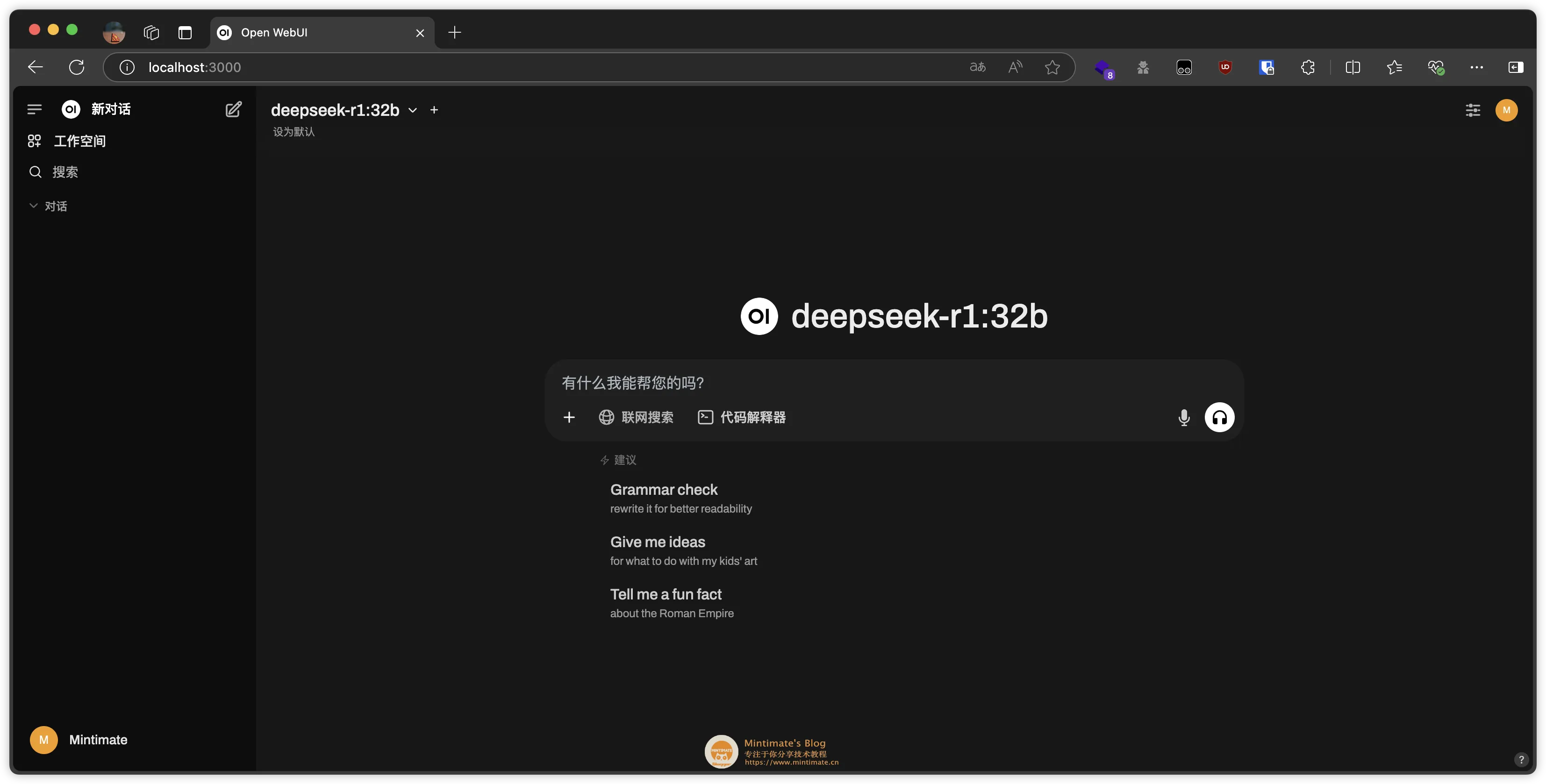

Open WebUI 界面

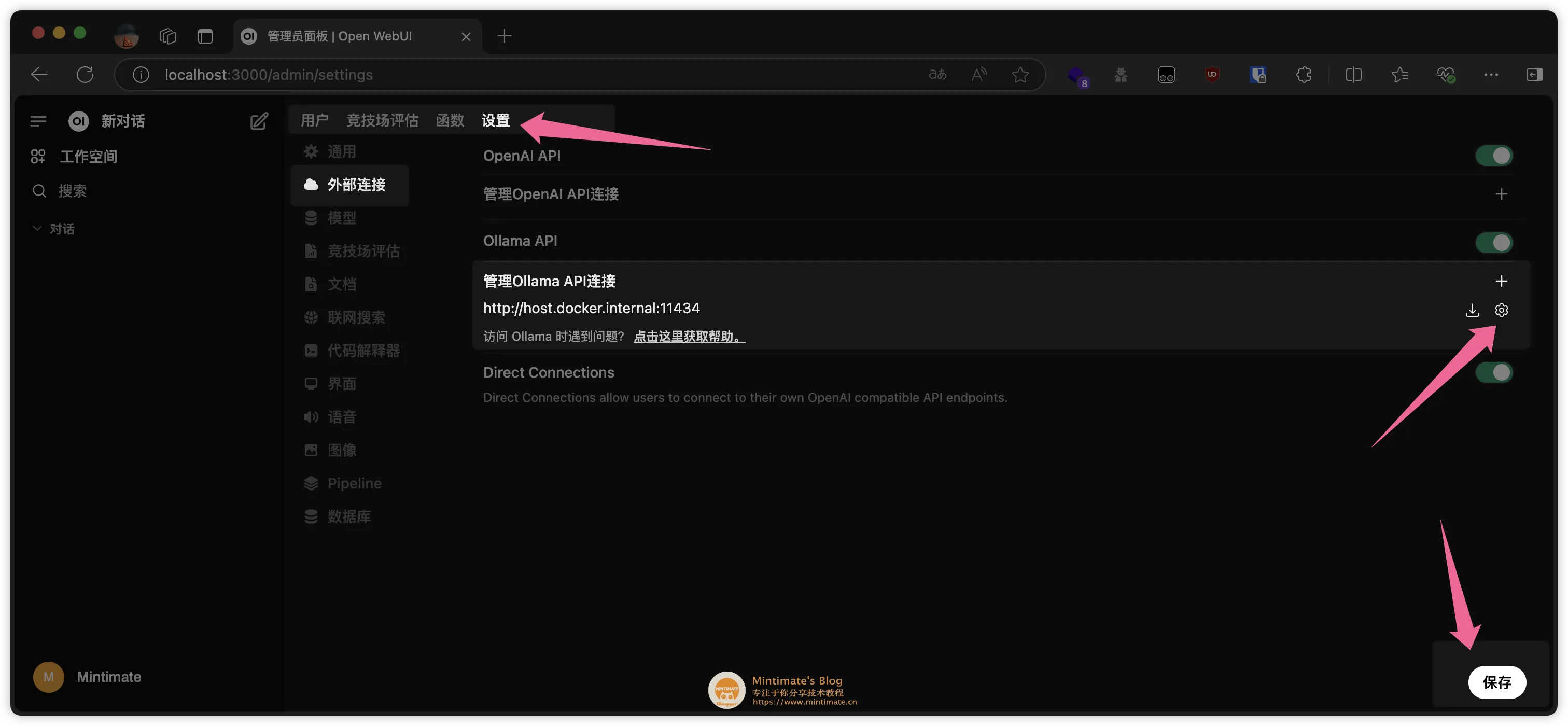

Open WebUI 界面其实本地 Open WebUI 和 Ollama 的配置,已经做到了开箱即用。存在部分情况需要设置 API 接口,或者设置远程 ollama 的接口用于本地调用。

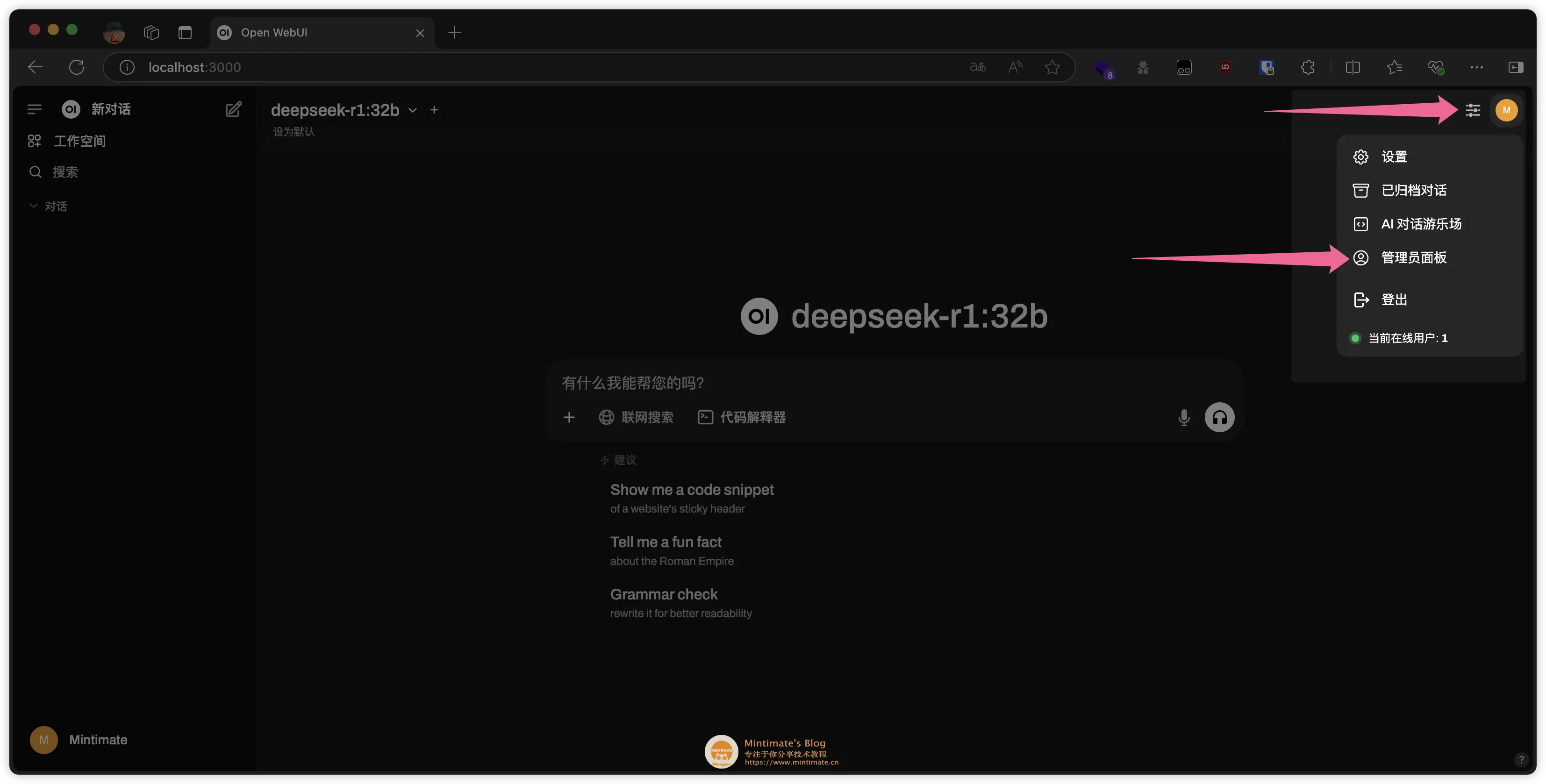

API 接口设置默认情况,Open WebUI 会使用 Ollama 的默认地址 http://localhost:11434 进行查询。没有显示模型,你可以在 Settings 中进行配置:

Open WebUI 配置

Open WebUI 配置 Open WebUI 配置详情

Open WebUI 配置详情联网查询我这里也提一下。一些小白用户,以为联网查询功能,是 DeepSeek 模型提供的;实际上,不管是 DeepSeek 官网,还是 Open WebUI,都是搜索 API 查询了网上结果后,作为 Token 内容喂给模型,之后输出结果。

相当于我们自己网上搜索了一下,把搜索结果作为附件,和提问内容一起给模型,模型输出结果。流程图:

联网查询

联网查询Open WebUI 的联网查询,就是使用搜索引擎 API,获取搜索结果。比如,我设置 duckduckgo 作为搜索引擎:

配置 duckduckgo

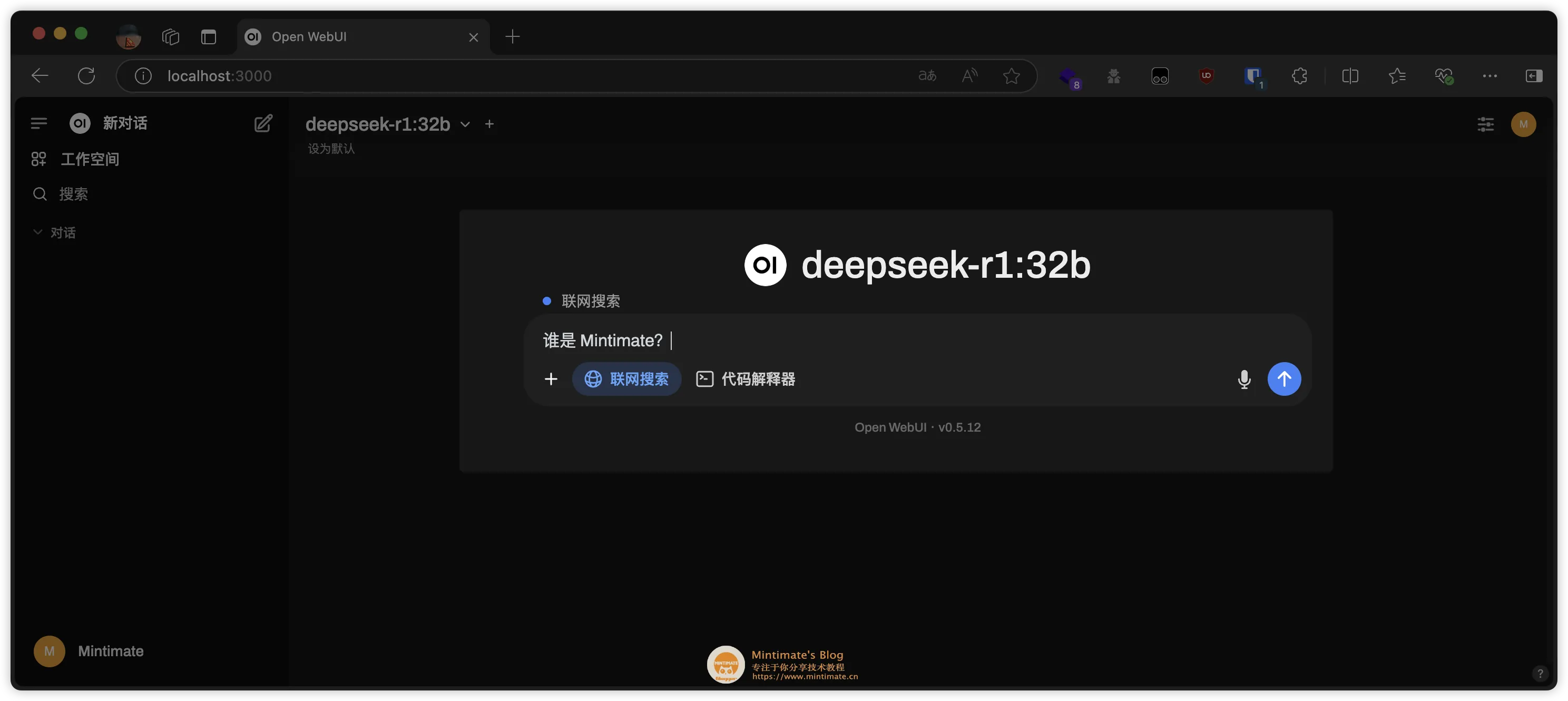

配置 duckduckgo 之后,在提问中,即可使用联网搜索功能:

使用 duckduckgo 搜索

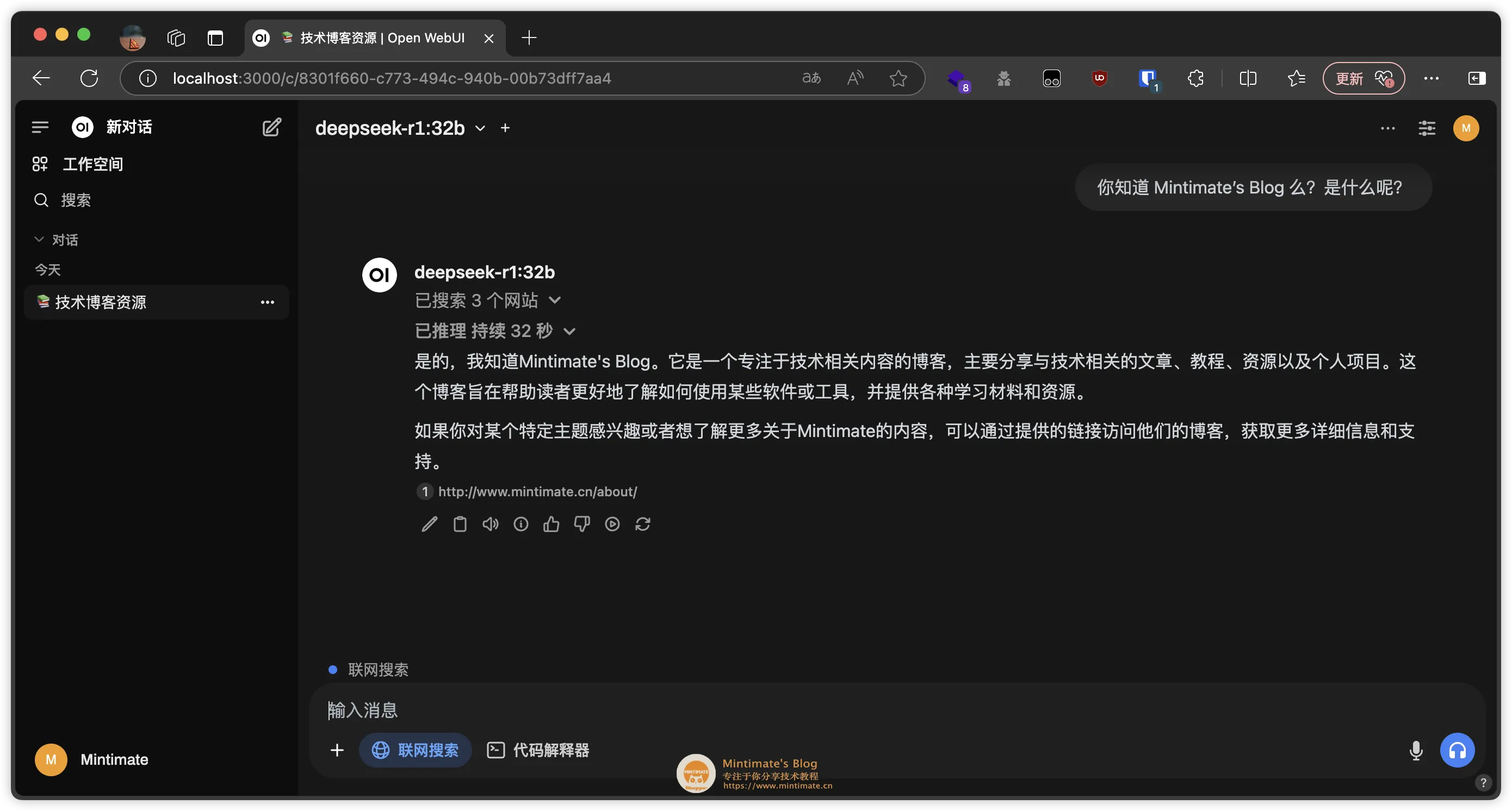

使用 duckduckgo 搜索最后的效果:

使用 duckduckgo 搜索结果

使用 duckduckgo 搜索结果这里,我收集了一些常见的问题,以及解决方案。

常见疑难问题?

常见疑难问题?参考 GitHub issue: How to remove ollama from macos?

注意:移除 Ollama 的配置文件和安装包,只是移除 Ollama 的本地数据,不会影响 Ollama 的模型。

如果你是 docker 部署的,那么移除容器就可以了:

代码语言:bash复制docker stop ollamadocker rm ollama登录后复制

如果你是直接安装的,那么需要先移除 Ollama 的配置文件,再移除 Ollama 的安装包:

代码语言:bash复制# 移除二进制文件rm /usr/local/bin/ollama # 删除软件rm -rf ~/Library/Application Support/Ollama登录后复制

最后,移除 Ollama 的登录项即可。

END感谢阅读,如果觉得不错,欢迎点赞、评论、转发。如果有什么问题,欢迎在评论区留言。有机会,我们一起看看本地知识库如何构建 ~~

福利游戏

相关文章

更多-

- 原神尘歌壶纳塔木材种类有哪些 原神尘歌壶纳塔木材种类介绍

- 时间:2025-04-28

-

- 航天模拟器如何发射火箭 航天模拟器发射火箭方法

- 时间:2025-04-28

-

- 燕云十六声玉门关阿依苏见闻怎么触发-燕云十六声玉门关阿依苏见闻大全

- 时间:2025-04-28

-

- 勇闯死人谷暗黑之日新手如何入门-勇闯死人谷暗黑之日新手入门攻略

- 时间:2025-04-28

-

- 百度文库智能助手入口 百度文库的ai文档助手在哪里

- 时间:2025-04-28

-

- PicoPico如何开启语音房隐身

- 时间:2025-04-28

-

- 优酷WPS会员如何取消

- 时间:2025-04-28

-

- 大学搜题酱app如何查找教材

- 时间:2025-04-28

精选合集

更多大家都在玩

大家都在看

更多-

- 米塔第14章怎么玩

- 时间:2025-04-28

-

- 米塔第12章怎么玩

- 时间:2025-04-28

-

- USD Coin发行量是多少 USD Coin是哪年发行的

- 时间:2025-04-28

-

- 米塔第1章怎么过

- 时间:2025-04-28

-

- 友商开始加入35mm俱乐部!努比亚已用上第五代:感谢认可

- 时间:2025-04-28

-

- 无光盘怎么重装win7系统

- 时间:2025-04-28

-

- 铭凡推出MS-A2迷你工作站:顶配锐龙9、双2.5G口

- 时间:2025-04-28

-

- 千元机新卷王!OPPO K12s全面评测:OPPO史上最大电池 五年不卡成为现实

- 时间:2025-04-28