Ming-lite-omni— 蚂蚁集团开源的统一多模态大模型

时间:2025-05-30 | 作者: | 阅读:0ming-lite-omni 是蚂蚁集团推出的一款开源的统一多模态大模型。该模型采用了 moe(mixture of experts)架构,整合了文本、图像、音频及视频等多种模态的信息处理能力,展现出卓越的理解与生成能力。在各类模态基准测试中,ming-lite-omni 在图像分类、视频解析以及语音应答等方面均取得了显著的成绩。它能够实现全方位的模态输入输出,为用户提供无缝衔接的多模态互动体验。此外,由于其高度的灵活性与扩展性,ming-lite-omni 能够被广泛应用于 ocr 识别、知识问答、视频评估等领域,展现出巨大的应用潜力。

Ming-Lite-Omni 的核心特性

Ming-Lite-Omni 的核心特性

- 多功能集成:兼容文本、图像、音频、视频等多种形式的输入输出,提供顺畅无阻的交互体验。

- 深度解析与创造:拥有强大的分析能力和创造力,可用于回答问题、生成文字、识别图像、分析视频等多种应用场景。

- 高性能运算:依托于 MoE 架构,优化了运算流程,提升了大数据处理的速度,并保证了实时响应的能力。

Ming-Lite-Omni 的核心技术框架

- Mixture of Experts (MoE) 模型结构:这是一种模型并行化的解决方案,通过将模型划分为若干个专家网络(Experts)和一个门控网络(Gating Network),使每个专家网络专注于处理特定类型的数据,而门控网络则负责分配数据至相应的专家。

- 多模态信息处理:针对每种模态(如文本、图像、音频、视频)设计了专门的路径规划方案,以保障模型能够精准高效地处理各种模态的数据。例如,在视频分析方面,利用 KV-Cache 动态压缩视觉 token,从而大幅减少长时间视频分析所需的计算资源。

- 综合理解与表达:采用编码器-解码器架构,其中编码器负责对输入信息进行深入理解,解码器则负责生成对应的输出结果。借助跨模态融合技术,可以将不同模态的数据有机结合,实现一致性的理解和生成效果。

- 训练与调整:模型先经过大规模的预训练来获取通用的模态特征,再通过微调的方式适配具体任务需求。同时,还运用了分层语料预训练策略和需求导向的执行优化体系,进一步增强了训练的效果和模型的表现力。

- 推理加速:基于混合线性注意力机制,降低了计算成本和内存使用率,解决了长序列推理中的效率障碍。此外,通过对推理流程的改进,确保了系统的即时反应能力,适用于那些对速度有严格要求的实际应用场合。

Ming-Lite-Omni 的官方资源链接

- Hugging Face 模型仓库:https://www.php.cn/link/74db80486179f9e43bed14f2d28c70a8

Ming-Lite-Omni 的典型应用场景

- 智能客服与语音助手:能够支持语音交流,迅速解决用户提出的问题,适合部署于智能客服系统或个人语音助手之中。

- 创意生产与编辑工具:帮助生成和修改文本、图像、视频等内容,促进创作者的工作效率。

- 教育服务与自主学习:根据个人的学习情况提供定制化的指导建议,辅助教师开展教学活动,推动教育数字化进程。

- 医疗卫生服务:协助医生审阅病历资料、解读医学影像,配合 AI 健康管理系统,改善医疗服务质量。

- 商务办公自动化:自动整理文件、记录会议要点,优化日常管理工作,为企业迈向智能化迈进铺平道路。

福利游戏

相关文章

更多-

- 医保电子凭证怎么激活 医保电子凭证激活方法快速上手

- 时间:2025-05-31

-

- 孩子小离不开人?宝妈在家赚钱的3个选择!

- 时间:2025-05-31

-

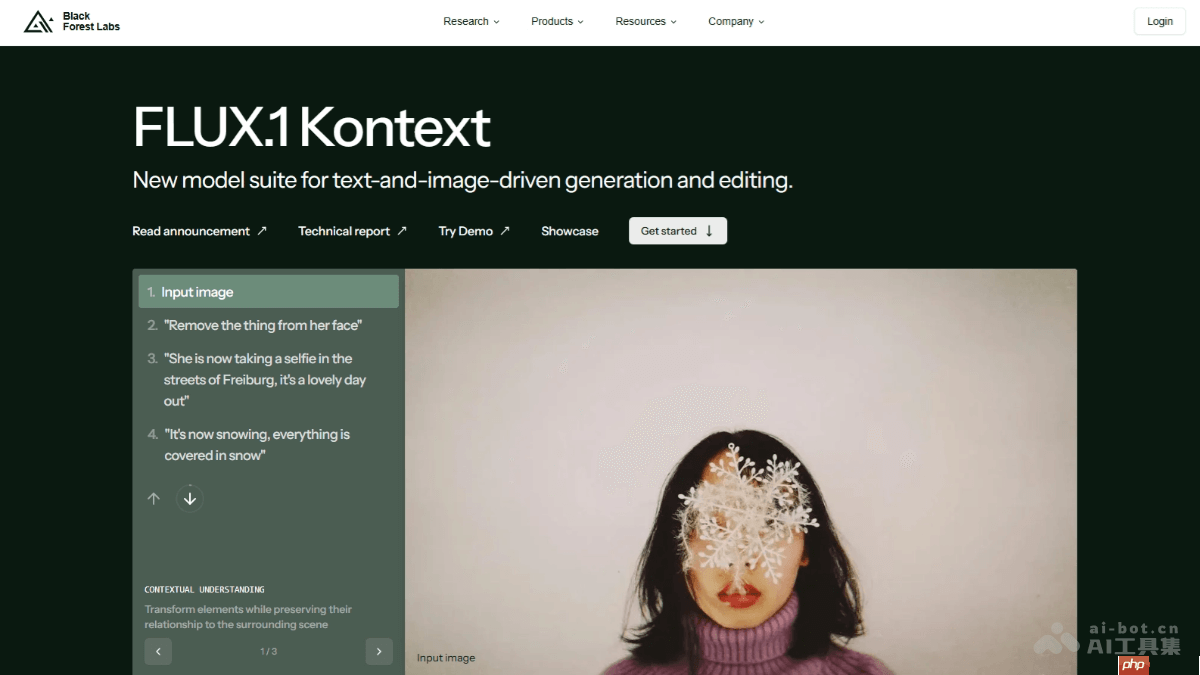

- FLUX.1 Kontext— Black Forest Labs 推出的图像生成与编辑模型

- 时间:2025-05-31

-

- Anthropic年化收入达30亿美元,AI代码生成成主要增长动力

- 时间:2025-05-31

-

- 尊界S800上市 首发华为ADS 4.0 售70.8万至101.8万

- 时间:2025-05-31

-

- 曝大部分尊界S800用户选择顶配车型:一小时订单破千

- 时间:2025-05-31

-

- 豆包AI神操作!用发疯文学做热点图阅读量三天破万

- 时间:2025-05-31

-

- 5寸是多少厘米 5寸换算厘米的实用技巧

- 时间:2025-05-31

精选合集

更多大家都在玩

大家都在看

更多-

- 区块链合约平台:开启全球交易新纪元

- 时间:2025-05-31

-

- 魔兽世界索罗夫宝藏获取方法

- 时间:2025-05-31

-

- Venom币起源:解决交易痛点

- 时间:2025-05-31

-

- 《金铲铲之战》三冠冕无限爆金币攻略

- 时间:2025-05-31

-

- 魔兽世界博学者的罩衫怎么获取

- 时间:2025-05-31

-

- Smittix预售筹1430万,瞄准跨境支付

- 时间:2025-05-31

-

- 鸣潮2.2幽夜幻梦任务流程

- 时间:2025-05-31

-

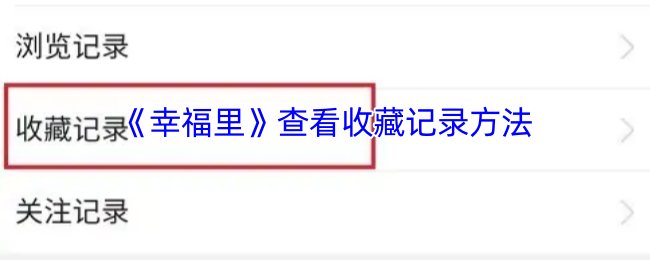

- 《幸福里》查看收藏记录方法

- 时间:2025-05-31