芯原超低能耗NPU可为移动端大语言模型推理提供超40 TOPS算力

时间:2025-06-10 | 作者: | 阅读:0

2025年6月9日,中国上海——芯原股份(芯原,股票代码:688521.SH)今日宣布其高性能且超低功耗的神经网络处理器(NPU)IP现已可在移动设备上实现大语言模型(LLM)推理,AI算力可扩展至超过40 TOPS。该NPU架构具有高能效比,专为满足移动平台不断增长的生成式AI需求而打造,不仅能为AI PC等终端设备提供强大算力支撑,同时也能应对智能手机等移动设备对低功耗提出的更高要求。

芯原的这款超低功耗NPU IP采用高度可配置和可扩展的设计,支持混合精度运算、稀疏优化以及并行处理能力。其架构融合了高效的内存管理机制与稀疏感知加速技术,显著减少计算负载和延迟,保障AI任务运行流畅、响应快速。该NPU可支持数百种AI算法,包括AI降噪(AI-NR)、AI超分辨率(AI-SR)等,并兼容Stable Diffusion和LLaMA-7B等主流AI模型。此外,该NPU IP还可与芯原其他处理器IP无缝结合,实现异构计算,帮助SoC设计者开发适用于多种场景的AI解决方案。

同时,芯原的NPU IP也全面兼容TensorFlow Lite、ONNX和PyTorch等主流AI框架,有助于客户加快在各类AI应用场景中的部署进度,并简化集成流程。

“随着生成式AI(AIGC)和多模态大语言模型的快速发展,智能手机等移动设备正逐步成为用户的个人AI中心,市场对AI算力的需求呈现爆发式增长,并已成为移动产品的重要差异化指标。”芯原首席战略官、执行副总裁兼IP事业部总经理戴伟进表示,“在应对高强度AI计算的过程中,如何有效控制功耗是最大挑战之一。芯原持续投入面向智能手机和AI PC的超低功耗NPU研发,并通过与主流SoC厂商的深度合作,成功推动该技术在新一代智能终端中实现量产落地。”

福利游戏

相关文章

更多-

- 医保断交之前的就白交了吗 医保断交影响解答疑惑

- 时间:2025-06-10

-

- 黑荆棘角斗场重制版种族区别

- 时间:2025-06-10

-

- 文心一言可以分析视频吗 文心一言视频分析功能揭秘

- 时间:2025-06-10

-

- 通义灵码生成流程图怎么弄

- 时间:2025-06-10

-

- 领克高管回应900车型西藏故障:加装防虫网致散热不良触发热保护

- 时间:2025-06-10

-

- BOE(京东方)“照亮成长路”公益项目新十年启幕 科技无界照亮美好未来

- 时间:2025-06-10

-

- 延宕!台积电日本、德国新厂建设计划或将调整

- 时间:2025-06-10

-

- 五分钟掌握DeepSeek+小红书爆款文案生成秘诀

- 时间:2025-06-10

大家都在玩

大家都在看

更多-

- GRT币详解:Web3.0数据索引新选择

- 时间:2025-06-10

-

- 原神寝正月初晴使用建议

- 时间:2025-06-10

-

- 彻底打通苹果生态!vivo X Fold5史无前例支持iCloud云端直连

- 时间:2025-06-10

-

- 苹果iOS 26被指卓里卓气 网友:这真的不是在致敬安卓么

- 时间:2025-06-10

-

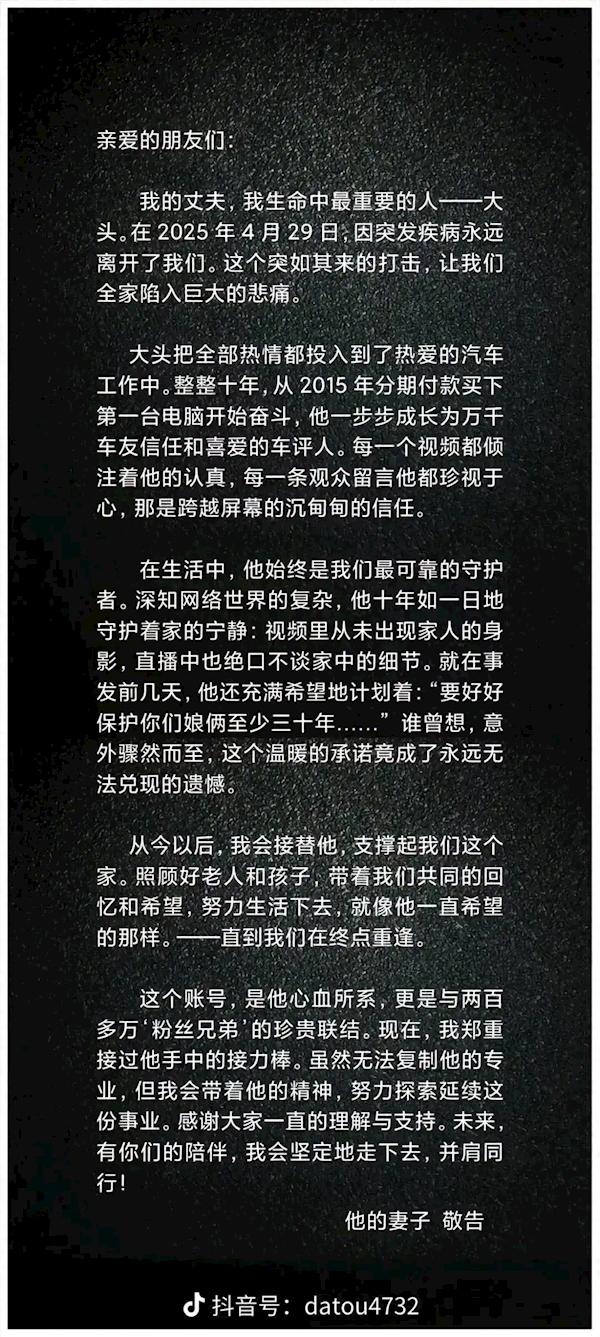

- 知名车评人大头突发疾病离世 妻子:将接过接力棒 延续他的事业

- 时间:2025-06-10

-

- 尊界S800店均新增大定20~30辆 大定用户多是劳斯莱斯、迈巴赫车主

- 时间:2025-06-10

-

- 原神游逸旅闻诗汇之章怎么玩 原神游逸旅闻诗汇之章活动全面解析

- 时间:2025-06-10

-

- Mini LED屏/320Hz刷新率!微星MPG 274URDFW E16M显示器图赏

- 时间:2025-06-10