如何使用LlamaIndex构建知识库 LlamaIndex接入大模型应用实例

时间:2025-07-01 | 作者: | 阅读:0llamaindex 可用于构建知识库并结合大模型实现问答功能。1. 数据准备与加载:使用 simpledirectoryreader 导入 pdf、word 等格式文档,转换为结构化数据;2. 构建索引:通过 vectorstoreindex 或 summaryindex 将文档转为向量存储,支持自定义嵌入模型;3. 查询接口搭建:利用 queryengine 接口发起查询,并可设置参数控制结果来源与输出模式;4. 部署与优化:封装为 web 服务,应用缓存、异步处理及模型调优等手段提升性能,并定期更新索引以保持内容同步。

LlamaIndex 是一个强大的工具,可以用来构建基于文档的知识库,并结合大模型(如 LLaMA、ChatGPT 等)实现问答、检索等功能。如果你有大量文本数据,想让 AI 帮你从中提取信息、回答问题,LlamaIndex 是个不错的选择。

下面我来分享几个关键点,告诉你如何用 LlamaIndex 搭建知识库,并接入大模型进行应用。

数据准备与加载:从原始内容到结构化输入

LlamaIndex 的第一步是把你的资料变成它能处理的形式。你可以导入 PDF、Word、Markdown、网页等各种格式的文本。它提供了一些现成的数据连接器(Data Loader),比如 SimpleDirectoryReader 可以读取整个文件夹下的文档。

举个例子,假设你有一堆 PDF 说明书,放在一个叫 docs 的文件夹里,代码大概是这样:

from llama_index import SimpleDirectoryReaderreader = SimpleDirectoryReader(input_dir='./docs')documents = reader.load_data()登录后复制

这一步完成后,你就得到了一个结构化的 documents 列表,接下来就可以构建索引了。

构建索引:让大模型“记住”你的数据

LlamaIndex 支持多种索引类型,最常用的是 VectorStoreIndex 和 SummaryIndex。前者适合做语义搜索,后者更适合做整体摘要。

构建索引的过程其实就是在将文档转换为向量表示,并存储起来。例如使用 VectorStoreIndex:

from llama_index import VectorStoreIndexindex = VectorStoreIndex.from_documents(documents)登录后复制

这里会调用默认的嵌入模型(Embedding Model),如果你有自己的模型或者想换一个效果更好的,也可以自定义。构建好之后,可以把 index 存下来,避免每次都要重新训练。

查询接口搭建:让大模型帮你回答问题

有了索引之后,就可以开始查询了。LlamaIndex 提供了一个 QueryEngine 接口,可以直接对索引发起提问:

query_engine = index.as_query_engine()response = query_engine.query(”产品A的操作流程是什么?“)print(response)登录后复制

这个过程背后其实是先通过向量匹配找到相关文档,再把这些文档作为上下文传给大模型,由大模型生成答案。

如果你希望控制回答的风格或限制来源,还可以设置参数,比如:

- similarity_top_k=3:只取最相关的三段话。

- response_mode="compact":控制输出是否合并多个结果。

部署与优化:让知识库真正跑起来

当你本地测试没问题后,下一步就是部署上线。你可以把它打包成 API 接口,比如用 FastAPI 或 Flask 封装成 Web 服务。

另外,一些常见的优化手段也别忘了:

- 使用缓存机制减少重复查询

- 设置异步任务处理长时间请求

- 对 embedding 模型和 LLM 做性能调优

如果你打算长期维护这个知识库,建议加上定期更新索引的功能,比如每天拉一次最新文档,保持内容同步。

基本上就这些。整个流程不算特别复杂,但每一步都有细节需要注意,尤其是索引构建和模型选择部分。不过只要按照步骤一步步来,就能快速搭出一个可用的知识库系统。

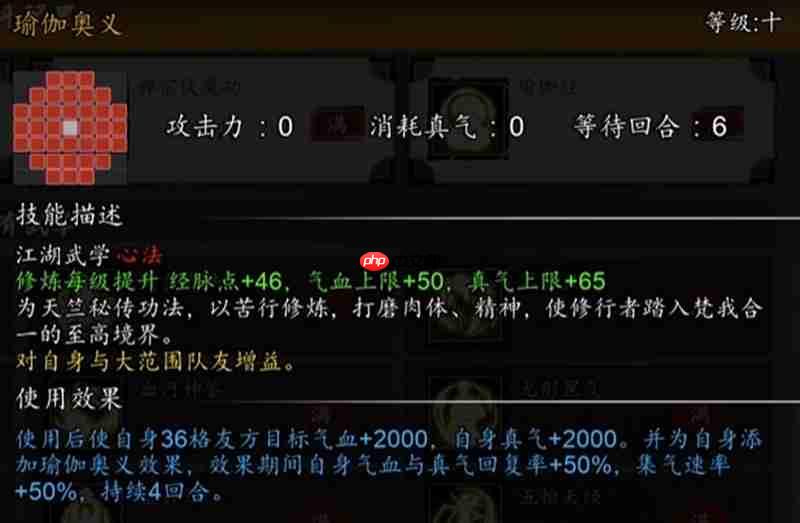

福利游戏

相关文章

更多-

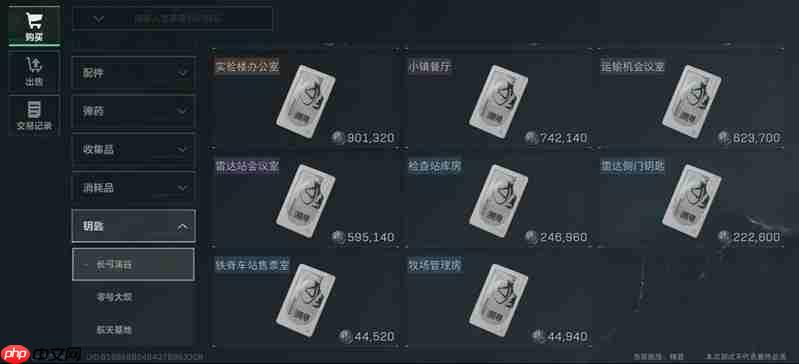

- 三角洲行动长弓溪谷钥匙房怎么刷 长弓溪谷钥匙房速刷方法

- 时间:2025-07-25

-

- 豆包AI怎样生成Markdown文档?技术文章排版自动化

- 时间:2025-07-25

-

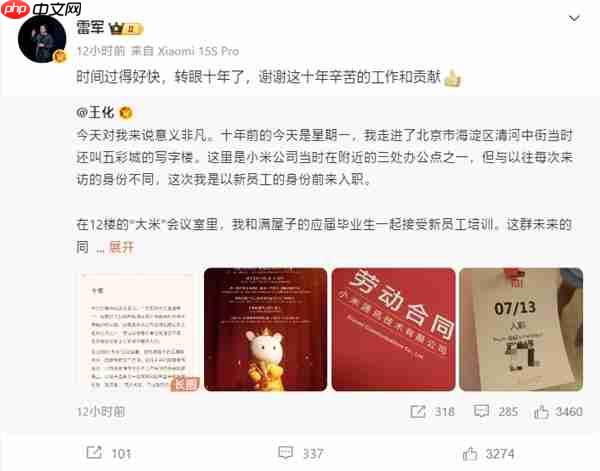

- 王化晒入职小米10周年纪念:雷军亲自感谢

- 时间:2025-07-25

-

- 逸剑风云决秘籍怎么获取 秘籍获取方式详细介绍

- 时间:2025-07-25

-

- 时光大爆炸蛮族入侵怎么玩 蛮族入侵玩法详细攻略

- 时间:2025-07-25

-

- 明日之后半感染者怎么变身 明日半感染者变身教程

- 时间:2025-07-25

-

- 奥特曼超时空英雄隐藏角色有哪些 隐藏英雄获取方法

- 时间:2025-07-25

-

- 七日世界哪里刷皮最多七日 熊洞高效刷皮地点分享

- 时间:2025-07-25

大家都在玩

大家都在看

更多-

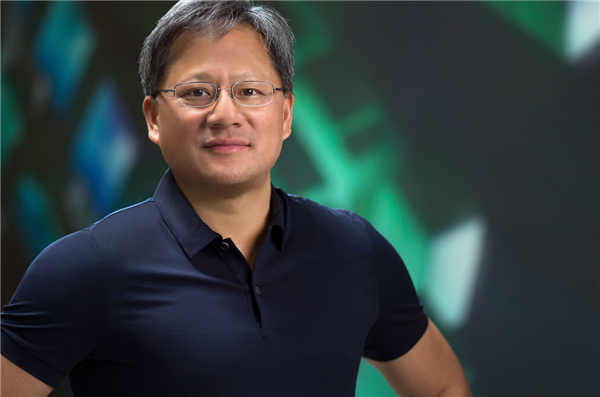

- 黄仁勋:英伟达离职率只有0.9% 随身携带秘密期权池奖励员工

- 时间:2025-07-25

-

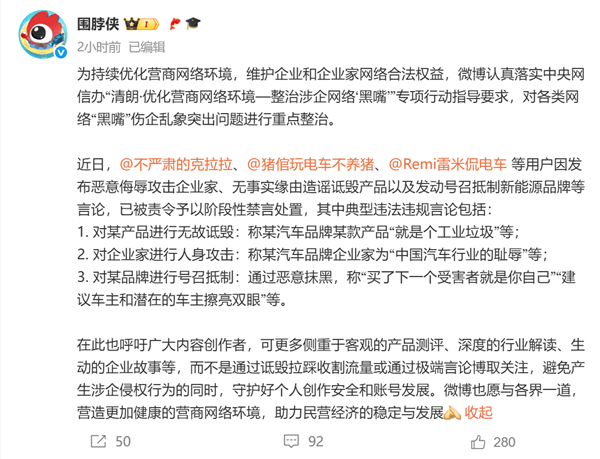

- 恶意侮辱攻击企业家、号召抵制新能源品牌!“雷米侃电车”等多位汽车博主被禁言

- 时间:2025-07-25

-

- ARKW转投加拿大比特币ETF

- 时间:2025-07-25

-

- 首款可折叠iPhone屏幕尺寸曝光:7.8英寸内屏+5.5英寸外屏

- 时间:2025-07-25

-

- 中国以太坊持有者最多的人是谁

- 时间:2025-07-25

-

- 玩明末:渊虚之羽时RTX 5090接口烧毁!资深编辑记录下完整过程

- 时间:2025-07-25

-

- 七彩虹限定熊猫游戏本首发8099元:熊猫主题设计 搭载星知岛AI

- 时间:2025-07-25

-

- 远光84变变龙怎么玩

- 时间:2025-07-25