多模态AI调用GPU资源过高 多模态AI计算资源占用优化方案

时间:2025-07-02 | 作者: | 阅读:0多模态人工智能在处理复杂任务时,常因巨大的计算需求导致图形处理器(GPU)资源占用过高。本文旨在探讨多模态AI计算资源占用高的原因,并提供一系列具体的优化方案。我们将从模型层面、数据处理、优化技术及软硬件配置等方面入手,分步骤讲解如何有效降低GPU负载,提升AI模型的运行效率。

多模态AI为何占用高GPU资源

多模态AI模型需要同时处理和理解来自不同模态(如视觉、听觉、文本)的数据。这种跨模态的整合和深度处理涉及的模型往往规模庞大、结构复杂,包含海量参数。在进行推理或训练时,模型需要执行大规模的并行计算和矩阵运算,这些计算密集型任务对GPU的计算能力、显存容量及带宽都构成了巨大挑战,从而导致资源占用居高不下。

选择模型时,优先考虑轻量化或经过优化的模型,这是降低初始资源需求的关键一步。

多模态AI计算资源优化方案

以下是优化多模态AI计算资源占用的具体步骤和建议:

1、评估与选择高效模型:并非所有任务都必须使用最大的模型。建议根据实际应用需求,权衡模型性能与资源消耗,选择参数量适中或经过剪枝、蒸馏等技术处理过的紧凑型模型。

2、优化数据加载与预处理:使用高效的数据加载管道,例如利用多进程或异步加载来确保GPU在计算时不会因等待数据而空闲。合理设置数据批次大小(batch size),它直接影响显存使用和计算并行度。

3、应用模型量化技术:将模型参数从浮点精度(如FP32)降低到较低精度(如FP16或INT8)。量化可以显著减少模型大小和计算时的内存带宽需求,同时多数情况下对模型性能影响较小。推荐尝试训练后量化或量化感知训练。

4、利用混合精度计算:现代深度学习框架支持在计算过程中混合使用不同精度(如FP16和FP32)。利用FP16进行大部分计算可以减少显存占用并加速计算,而将部分关键计算保留在FP32以保持精度。这是一种推荐的优化手段。

混合精度训练/推理是减少GPU显存和提高计算速度的常用且有效的技术,推荐优先尝试。

5、更新驱动和优化软件环境:确保GPU驱动程序、CUDA、cuDNN以及所使用的深度学习框架(如PyTorch, TensorFlow)都是最新且与硬件兼容的版本。这些更新通常包含了性能优化。合理配置框架参数,启用自动调优功能。

优化数据加载 pipeline 可以减少GPU等待数据的时间,提高整体计算资源的利用率。

通过系统性地应用上述优化策略,可以在不显著牺牲模型性能的前提下,有效降低多模态AI模型对GPU资源的占用,提高计算效率。

来源:https://www.php.cn/faq/1385550.html

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- nef 格式图片降噪处理用什么工具 效果如何

- 时间:2025-07-29

-

- 邮箱长时间未登录被注销了能恢复吗?

- 时间:2025-07-29

-

- Outlook收件箱邮件不同步怎么办?

- 时间:2025-07-29

-

- 为什么客户端收邮件总是延迟?

- 时间:2025-07-29

-

- 一英寸在磁带宽度中是多少 老式设备规格

- 时间:2025-07-29

-

- 大卡和年龄的关系 不同年龄段热量需求

- 时间:2025-07-29

-

- jif 格式是 gif 的变体吗 现在还常用吗

- 时间:2025-07-29

-

- hdr 格式图片在显示器上能完全显示吗 普通显示器有局限吗

- 时间:2025-07-29

大家都在玩

热门话题

大家都在看

更多-

- Web3钱包里的币如何出售?Web3钱包币出售教程

- 时间:2025-09-11

-

- 加密老妈Hester Peirce声明:为新加密货币工作组列出10个优先事项

- 时间:2025-09-11

-

- USDT币商如何获取的低价币?USDT低价出骗局有哪些?

- 时间:2025-09-11

-

- 特 朗普:美国退出联合国人权理事会、不急于和中国谈判!比特币下杀9.6万美元

- 时间:2025-09-11

-

- PS怎么更改内存容量

- 时间:2025-09-11

-

- 虚拟币跨链如何追踪交易?跨链桥如何运作?

- 时间:2025-09-11

-

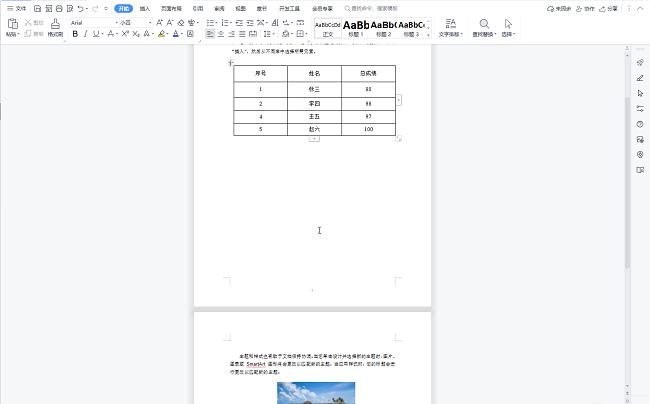

- WPS有空白处但是字上不去怎么办

- 时间:2025-09-11

-

- OTC交易代表什么?OTC交易合法吗?

- 时间:2025-09-11