多模态AI模型安全加固措施 多模态AI防护配置指南

时间:2025-07-03 | 作者: | 阅读:0多模态ai模型的安全性可通过四方面措施加强:1. 多模态内容过滤,包括使用先进算法、定期更新规则、设置多层验证;2. 防范对抗攻击,通过增强鲁棒性、实时监控、数据预处理;3. 跨域安全防护,实施传输过滤、加密通信、访问控制;4. 指令遵循与幻觉抑制,优化指令数据、提升泛化能力、建立检测机制。

多模态AI模型在当前的应用中越来越广泛,但同时也面临不少安全挑战。为了确保这类模型的安全性,需要从多个方面进行加固和防护配置。

多模态内容过滤

多模态内容过滤是保护AI系统免受有害或敏感信息侵害的重要措施。以下是几个建议:

- 使用先进的过滤算法:采用最新的深度学习技术来识别和过滤图片、文本、音频等多模态数据中的有害内容。

- 定期更新过滤规则:随着新类型的恶意提示词不断出现,定期更新过滤规则可以保持系统的有效性。

- 多层验证机制:设置多层验证机制,确保不同模态的数据在进入系统前经过严格检查。

防范对抗攻击

对抗攻击是指通过微小扰动使AI模型做出错误判断的行为。以下是一些防范措施:

- 增强模型鲁棒性:训练模型时加入对抗样本,提高其对扰动的容忍度。

- 实时监控与检测:部署实时监控系统,及时发现并阻止潜在的对抗攻击。

- 数据预处理:在输入数据进入模型之前,进行标准化和清理,以减少攻击面。

跨域安全防护

跨域操作可能会引入额外的安全风险,特别是在物理域和信息域之间的交互中。以下是一些建议:

- 嵌入传输数据过滤检查:在数据传输过程中,实施过滤检查,防止恶意数据渗透。

- 加密通信:使用强加密协议保护跨域传输的数据,防止中间人攻击。

- 访问控制:严格管理用户和设备的访问权限,确保只有授权实体才能进行跨域操作。

指令遵循与幻觉抑制

大模型的指令遵循能力和幻觉抑制是保证其可靠性的关键因素:

- 优化指令数据构建:设计高质量的指令数据集,确保模型能够准确理解和执行指令。

- 提升泛化能力:通过多样化的训练数据和场景,提高模型在面对新任务时的表现。

- 幻觉检测机制:开发专门的检测机制,识别并纠正模型生成的虚假信息。

基本上就这些。

福利游戏

相关文章

更多-

- 飞桨常规赛:英雄联盟大师预测赛1月第四名方案分享

- 时间:2025-07-28

-

- 如何用豆包 AI 大模型与 AI 宠物训练工具配合,让宠物更听话??

- 时间:2025-07-28

-

- 导盲赛道思路分享

- 时间:2025-07-28

-

- DDRNet-通过PaddleSeg实现全流程跑通

- 时间:2025-07-28

-

- 如何用夸克AI大模型分析PDF文件 夸克AI大模型文档理解能力展示

- 时间:2025-07-28

-

- 美团外卖新人红包怎么领 美团优惠券首单专属优惠领取

- 时间:2025-07-28

-

- 美团红包领取入口正式上线 美团优惠券领取渠道大公开

- 时间:2025-07-28

-

- 美团本地餐饮优惠券怎么领 美团吃饭先领券再下单更省

- 时间:2025-07-28

大家都在玩

大家都在看

更多-

- 明日方舟官方回应内容被泄露:严肃追究相关责任!

- 时间:2025-07-27

-

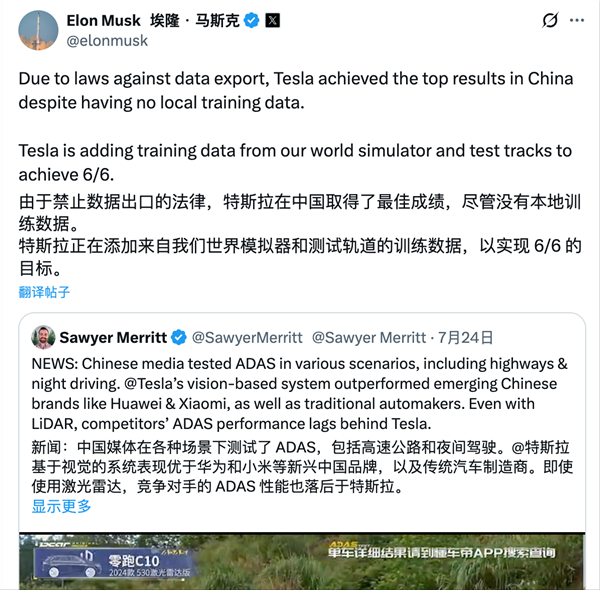

- 特斯拉是赢了 但不是真相的全部

- 时间:2025-07-27

-

- 历史性突破!国内单套规模最大乙醇脱水制乙烯装置投产

- 时间:2025-07-27

-

- IE浏览器升级攻略:安全防护新选择

- 时间:2025-07-27

-

- 艾达币是什么?艾达币是数字货币吗?艾达币来源及意思详解

- 时间:2025-07-27

-

- BitfinexAPP怎么查看行情

- 时间:2025-07-27

-

- 加密货币购买时机?Web3 AI或成黑马

- 时间:2025-07-27

-

- KOMA币投资指南:小众币的暴富机会?

- 时间:2025-07-27