DeepSeek R1T2— TNG推出的改进型AI语言模型,基于DeepSeek

时间:2025-07-12 | 作者: | 阅读:0deepseek r1t2 是 tng 在 deepseek 原始模型基础上开发的增强型语言模型。该模型采用 tri-mind 架构,融合了 deepseek r1-0528、r1 和 v3-0324 三个基础模型的优势,通过 assembly of experts(aoe)技术整合推理能力、结构化思维和简洁指令导向行为。相比 r1-0528,r1t2 的推理速度提升了 200%,比 r1 快 20%,输出长度减少 60%,显著降低了计算开销。在智能评测中表现接近 r1-0528 水平,并修复了初代 r1t 的不足。适用于对推理能力有要求且注重效率与成本的企业应用场景,是 r1 的优化升级版本。

- 高效推理与加速:推理速度比 R1-0528 提升 200%,比 R1 提升 20%。token 输出量减少至前者的 40%,有效降低运行时间和资源消耗。

- 智能与效率兼顾:Tri-Mind 架构结合了 R1-0528 的逻辑推理、R1 的结构化处理以及 V3-0324 的指令响应能力,在 GPQA 和 AIME-2024 测试中优于 R1,达到 R1-0528 智能水平的 90%-92%。

- 输出精简与成本控制:输出平均精简度比 R1 高出约 20%,适合高吞吐或预算受限的部署场景,具有更高的经济实用性。

- 对话稳定性提升:即使没有系统提示,也能提供稳定自然的交互体验,改善了初代 R1T 的不足。

- 开源可定制:已在 Hugging Face 开源,采用 MIT 协议,支持微调、强化学习及私有部署。

核心技术机制

- Tri-Mind 结构设计:整合 DeepSeek R1-0528、R1 及 V3-0324 的特性,兼具强推理、结构化处理与简洁响应机制。

- 专家张量融合技术(AoE):通过加权合并多个预训练模型的参数张量构建而成,不同于传统 MoE 的动态激活机制,AoE 在权重层面融合,保留父模型优势并减少冗余输出。

- 提升推理效率:输出 token 数量仅为 R1-0528 的 40%,大幅缩短响应时间与运算负载;相较 R1,输出更精炼,效率更高。

- 维持智能水准:尽管压缩输出长度,但在 GPQA Diamond 与 AIME 系列测试中仍表现出色,达到 R1-0528 智能等级的 90%-92%。

- 专家融合策略:结合 R1 的专家张量与 V3-0324 的架构,选择性继承 R1-0528 的改进成果,实现推理质量与成本之间的平衡。

- 无需额外训练:通过参数插值与融合直接构建,避免了重新训练带来的开销,快速集成父模型能力。

- 行为一致性保障:保留 R1 的逐步推理模式,满足复杂任务需求。

项目地址

- HuggingFace 页面:https://www.php.cn/link/f288f46c5d79de67251ea00e6c7970f6

典型应用场景

- 数学解题辅助:具备解决复杂数学问题的能力,提供分步解析,适用于教育辅导工具。

- 代码生成与纠错:可根据指令生成代码片段、自动补全代码,并进行错误诊断与修正建议。

- 金融建模与分析:适用于大规模企业级任务,如金融策略制定与数据解读。

- 智能客服与知识库应用:可用于构建企业知识管理系统,提高客服问答的准确率与响应效率。

来源:https://www.php.cn/faq/1402374.html

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- nef 格式图片降噪处理用什么工具 效果如何

- 时间:2025-07-29

-

- 邮箱长时间未登录被注销了能恢复吗?

- 时间:2025-07-29

-

- Outlook收件箱邮件不同步怎么办?

- 时间:2025-07-29

-

- 为什么客户端收邮件总是延迟?

- 时间:2025-07-29

-

- 一英寸在磁带宽度中是多少 老式设备规格

- 时间:2025-07-29

-

- 大卡和年龄的关系 不同年龄段热量需求

- 时间:2025-07-29

-

- jif 格式是 gif 的变体吗 现在还常用吗

- 时间:2025-07-29

-

- hdr 格式图片在显示器上能完全显示吗 普通显示器有局限吗

- 时间:2025-07-29

大家都在玩

大家都在看

更多-

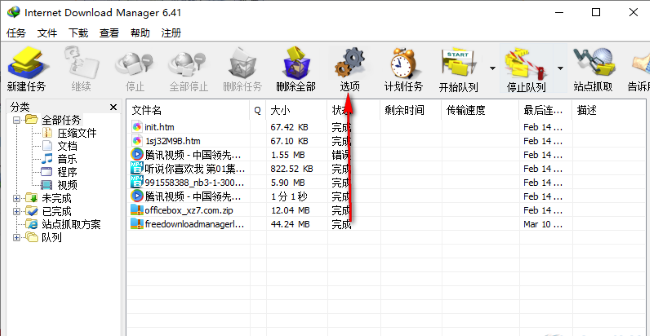

- IDM下载器怎么设置限速

- 时间:2025-10-11

-

- IDM下载器如何设置线程数量

- 时间:2025-10-11

-

- 网球宝贝游戏名字

- 时间:2025-10-11

-

- 怎样删除抖音评论的回复?删除抖音评论的回复能看到吗?

- 时间:2025-10-11

-

- 短视频平台引流方法是什么?平台引流违法吗?

- 时间:2025-10-11

-

- 如何批量删除快手发布的作品?批量删除快手发布的作品会怎样?

- 时间:2025-10-11

-

- 抖音商品链接怎么复制?它的商品链接要怎么挂上去?

- 时间:2025-10-11

-

- 多账号矩阵该如何打造?矩阵带来的好处和价值是什么?

- 时间:2025-10-11