值分布强化学习 —— C51

时间:2025-07-21 | 作者: | 阅读:0值分布强化学习是基于价值的强化学习算法,不同于传统方法仅建模累积回报期望值,它对整个分布Z(s,a)建模以保留分布信息。C51是其代表算法,将分布离散为51个支点,输出支点概率,通过投影贝尔曼更新处理分布范围问题,损失函数用KL散度,框架与DQN类似但输出和更新方式不同。

值分布强化学习简介

首先需要声明的是,值分布强化学习(Distributional Reinforcement Learning)是一类基于价值的强化学习算法(value-based Reinforcement Learning)

经典的基于价值的强化学习方法使用期望值对累积回报进行建模,表示为价值函数 V(s) 或动作价值函数 Q(s,a)

而在这个建模过程中,完整的分布信息在很大程度上被丢失了

提出值分布强化学习就是想要解决分布信息丢失这个问题,对累积回报随机变量的整个分布 Z(s,a) 进行建模,而非只建模其期望

如果用公式表示:

Q(st,at)=EZ(st,at)=E[i=1∑∞γt+iR(st+i,at+i)]

值分布强化学习——C51算法

C51 简介

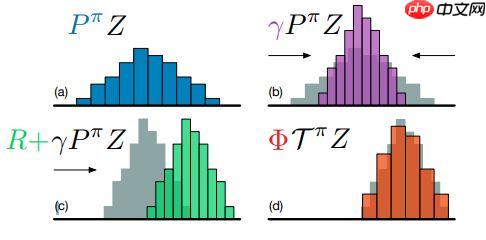

C51 算法来自 DeepMind 的?A Distributional Perspective on Reinforcement Learning?一文。在这篇文章中,作者首先说明传统 DQN 算法希望学习的 Q 是一个数值,其含义是未来奖励和的期望。而在值分布强化学习系列算法中,目标则由数值变为一个分布。在值分布强化学习中,目标也由数值 Q 变为随机变量 Z,这种改变可以使学到的内容是除了数值以外的更多信息,即整个分布。而模型返回的损失也转变为两个分布之间相似度的度量(metric)。

? ? ? ?算法关键

参数化分布

简而言之,若分布取值范围为Vmin到Vmax,并均分为离散的N个点,每个等分支集为

{zi=Vmin+iΔz:0≤i 模型输出的每个值对应取当前支点的概率投影贝尔曼更新

来源:https://www.php.cn/faq/1419350.html

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- nef 格式图片降噪处理用什么工具 效果如何

- 时间:2025-07-29

-

- 邮箱长时间未登录被注销了能恢复吗?

- 时间:2025-07-29

-

- Outlook收件箱邮件不同步怎么办?

- 时间:2025-07-29

-

- 为什么客户端收邮件总是延迟?

- 时间:2025-07-29

-

- 一英寸在磁带宽度中是多少 老式设备规格

- 时间:2025-07-29

-

- 大卡和年龄的关系 不同年龄段热量需求

- 时间:2025-07-29

-

- jif 格式是 gif 的变体吗 现在还常用吗

- 时间:2025-07-29

-

- hdr 格式图片在显示器上能完全显示吗 普通显示器有局限吗

- 时间:2025-07-29

大家都在玩

大家都在看

更多-

- 每日英语听力app有什么

- 时间:2025-11-11

-

- 绯月絮语莲华怎么样

- 时间:2025-11-11

-

- 绯月絮语角色有哪些

- 时间:2025-11-11

-

- 优酷客户端怎么设置下载路径

- 时间:2025-11-11

-

- QQ音乐怎么调整播放倍速

- 时间:2025-11-11

-

- lol游戏名字有深意

- 时间:2025-11-11

-

- 约翰的农场如何通关

- 时间:2025-11-11

-

- “宝,你皮一下,对方忍不住秒回”

- 时间:2025-11-11