GLM-4.5— 智谱推出的面向推理、代码与智能体的开源 SOTA 模型

时间:2025-07-29 | 作者: | 阅读:0GLM-4.5是什么

glm-4.5 是智谱推出的新一代旗舰模型,专为智能体应用打造,是首款原生融合推理、代码和智能体能力的开源 sota 模型。采用混合专家(moe)架构,有两个版本:glm-4.5(3550 亿参数,320 亿激活)和 glm-4.5-air(1060 亿参数,120 亿激活)。模型在多个评测基准中表现卓越,综合性能达到开源模型的顶尖水平,尤其在代码智能体场景中表现优异。支持混合推理模式,提供思考模式和非思考模式,兼顾复杂任务和即时响应需求。

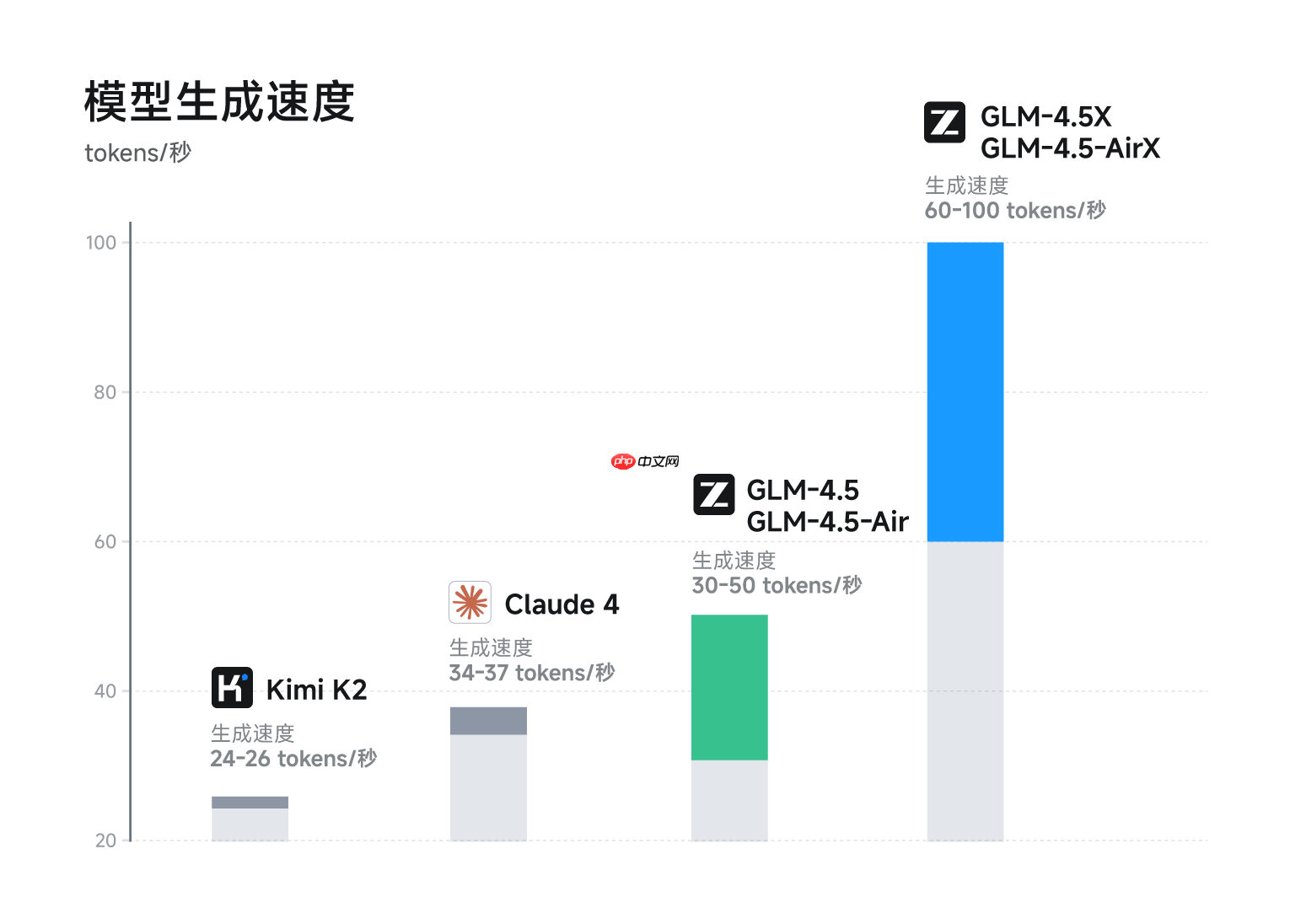

参数效率翻倍,API价格仅为Claude的1/10,速度最快可达100tokens/秒。率先在一个模型中实现多能力原生融合并取得重要技术突破——单个模型同时具备强大的推理、代码、智能体等能力,已上线智谱清言和Z.ai开放免费体验。

GLM-4.5的主要特点

- 多能力融合:首次在单个模型中实现了推理、代码生成和智能体能力的原生融合,能满足复杂智能体应用的需求。

- 推理能力:在多个推理评测基准中表现优异,支持复杂推理任务,推理性能达到开源模型的顶尖水平。

- 代码生成:在代码生成和编程任务中表现出色,支持多种编程语言,能生成高质量的代码片段,胜任全栈开发任务。

- 智能体应用:支持工具调用、网页浏览等功能,能接入代码智能体框架,如 Claude Code 和 Roo Code,适用于智能体任务。

- 混合推理模式:提供“思考模式”用于复杂推理和工具使用,以及“非思考模式”用于即时响应,兼顾效率和性能。

GLM-4.5的技术亮点

- 混合专家(MoE)架构:GLM-4.5 采用了混合专家(Mixture of Experts, MoE)架构,是一种高效的模型扩展方法。MoE 架构通过将模型参数划分为多个专家模块(Experts),在每个前向传播过程中动态选择部分专家进行激活,实现参数的稀疏激活。在保持模型强大表达能力的同时,显著降低了计算成本和内存占用。

- GLM-4.5:总参数量为 3550 亿,激活参数为 320 亿。

- GLM-4.5-Air:总参数量为 1060 亿,激活参数为 120 亿。

- 多模态能力:GLM-4.5 支持多模态输入和输出,能处理文本、图像等多种数据类型。使模型能更好地理解和生成复杂的智能体应用内容,例如在智能体任务中处理网页浏览、工具调用等多模态交互场景。

- 混合推理模式:GLM-4.5 提供两种推理模式:

- 思考模式(Thinking Mode):适用于复杂推理和工具使用场景,模型会进行更深入的思考和推理,以生成更准确的结果。

- 非思考模式(Non-Thinking Mode):适用于即时响应场景,模型会快速生成结果,满足低延迟的需求。

- 高效的训练流程:GLM-4.5 的训练流程包括三个阶段:

- 通用数据预训练:在 15 万亿 token 的通用数据上进行预训练,以学习语言和知识的基础表示。

- 针对性训练:在代码、推理、智能体等领域的 8 万亿 token 数据上进行针对性训练,以增强模型在特定任务上的表现。

- 强化学习优化:通过强化学习进一步优化模型的推理、代码生成和智能体能力,以提升模型在实际应用中的表现。

- 参数效率优化:GLM-4.5 在参数效率上实现了显著提升。尽管参数量仅为 DeepSeek-R1 的 1/2 和 Kimi-K2 的 1/3,但在多项标准基准测试中表现更为出色。例如,在 100B 总参数 – 10B 激活参数规模的模型系列中,GLM-4.5 在 Artificial Analysis 基准测试中的推理性能媲美甚至超越了其他国际顶级模型。

GLM-4.5的项目地址

- GitHub仓库:http://github.com/zai-org/GLM-4.5

- HuggingFace仓库: http://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b

- ModelScope仓库:http://modelscope.cn/collections/GLM-45-b8693e2a08984f

- 体验地址:

- HuggingFace: http://huggingface.co/spaces/zai-org/GLM-4.5-Space

- ModelScope:http://modelscope.cn/studios/ZhipuAI/GLM-4.5-Demo

GLM-4.5的技术指标

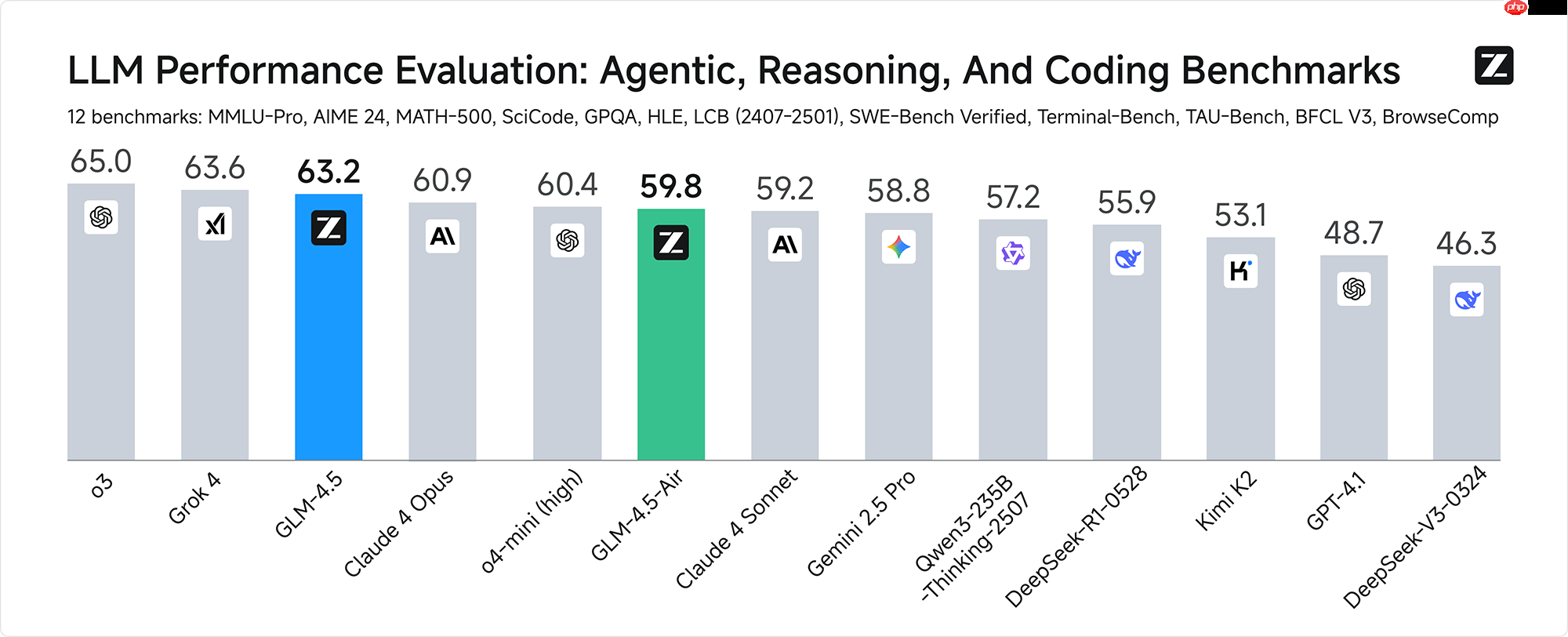

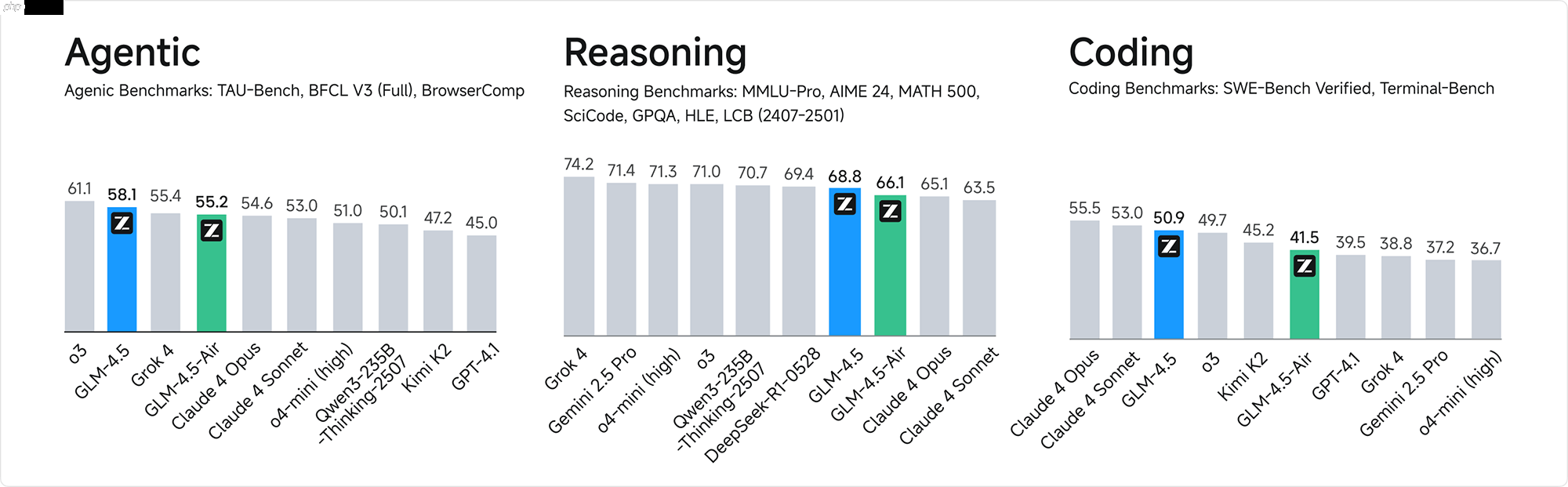

- 综合性能SOTA:最具有代表性的12个评测基准,包括 MMLU Pro、AIME 24、MATH 500、SciCode、GPQA 、HLE、LiveCodeBench、SWE-Bench Verified、Terminal-Bench、TAU-Bench、BFCL v3 和BrowseComp。综合平均分,GLM-4.5 取得了全球模型第三、国产模型第一,开源模型第一。

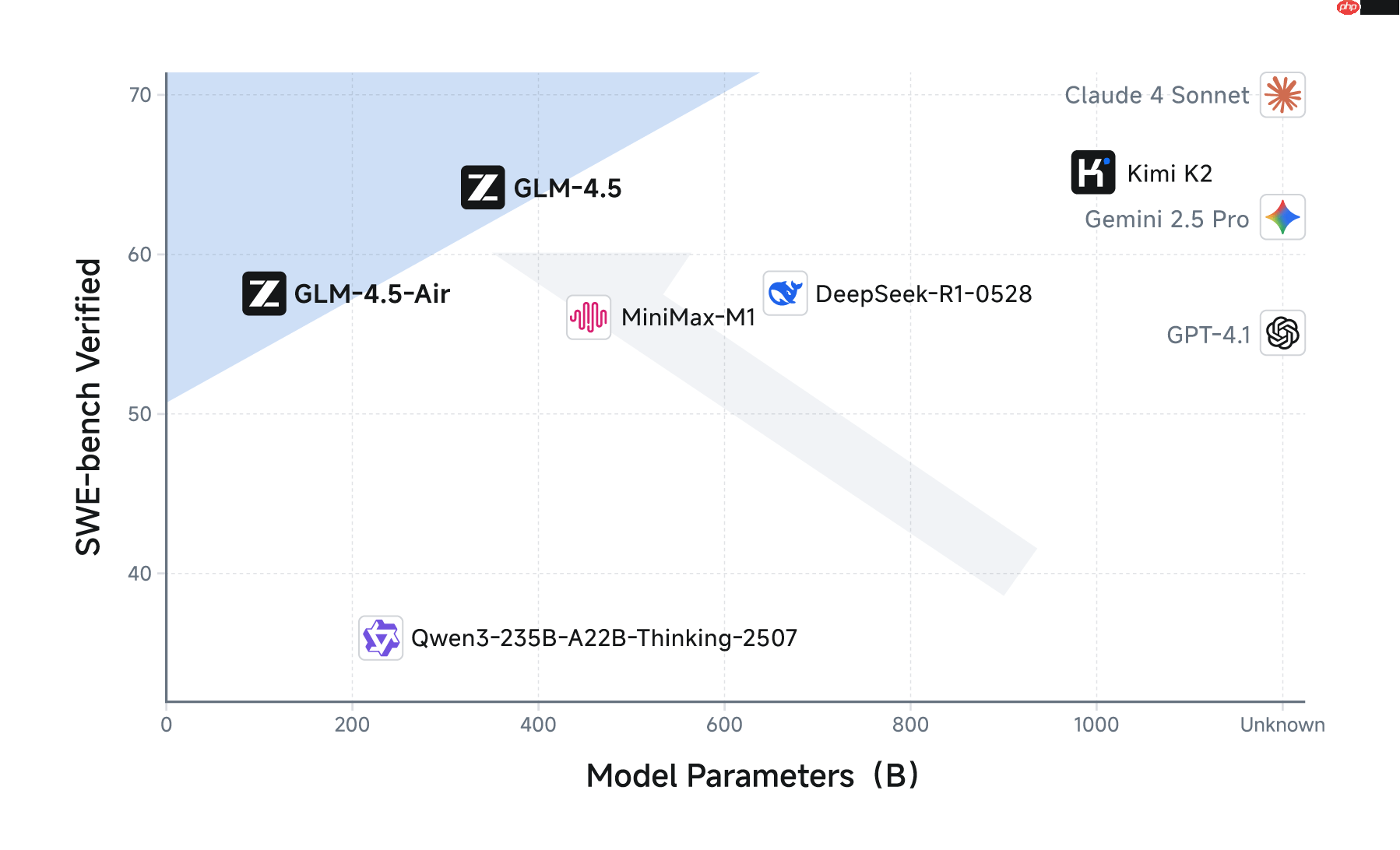

- 更高的参数效率:GLM-4.5 参数量为 DeepSeek-R1 的 1/2、Kimi-K2 的 1/3,但在多项标准基准测试中表现得更为出色,这得益于GLM模型的更高参数效率。在衡量模型代码能力的 SWE-bench Verified 榜单上,GLM-4.5 系列位于性能/参数比帕累托前沿,这表明在相同规模下,GLM-4.5 系列实现了最佳性能。

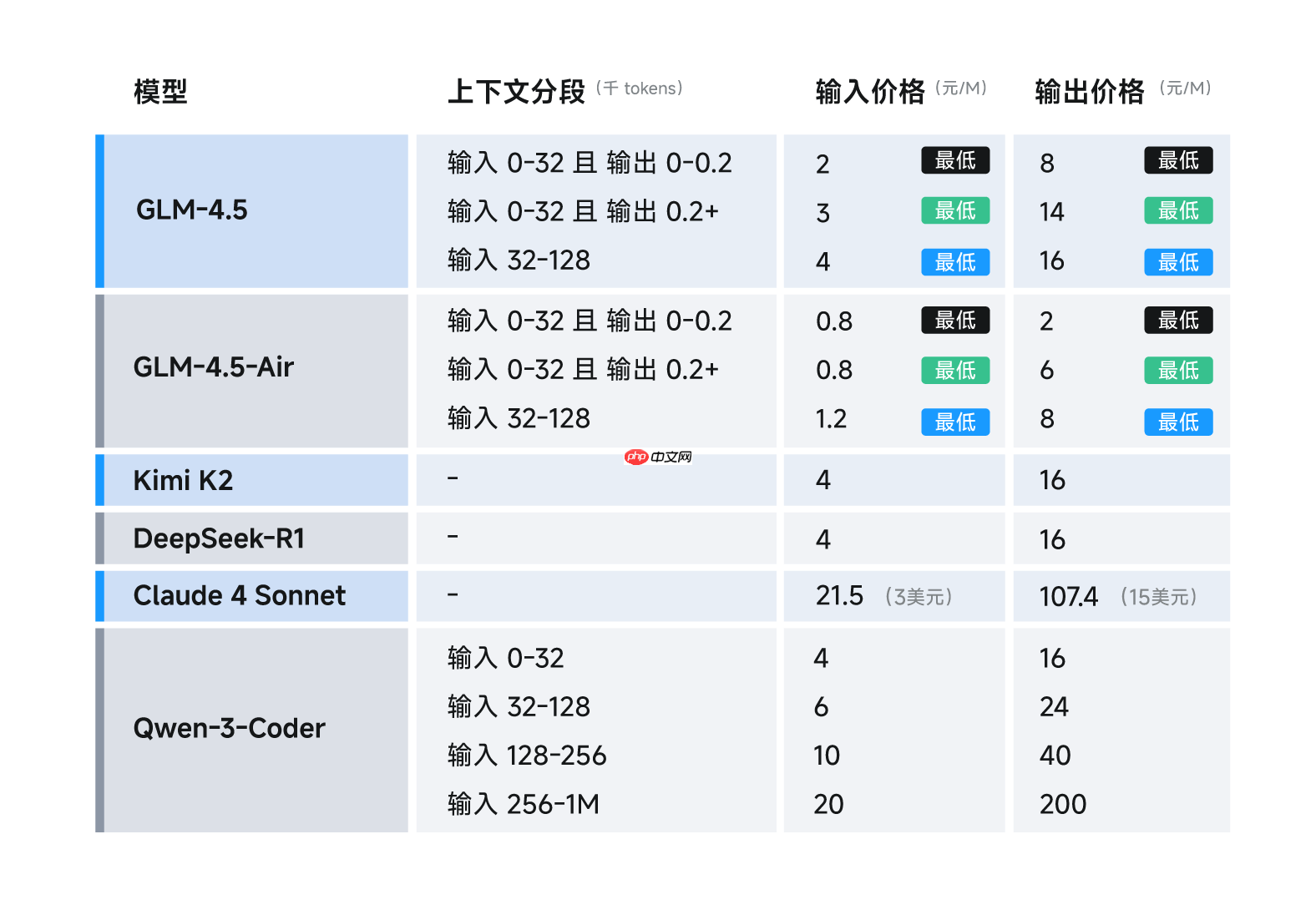

- 低成本、高速度:在性能优化之外,GLM-4.5 系列也在成本和效率上实现突破,由此带来远低于主流模型定价:API 调用价格低至输入 0.8 元/百万 tokens,输出 2 元/百万 tokens。同时,高速版本实测生成速度最高可至 100 tokens/秒,支持低延迟、高并发的实际部署需求,兼顾成本效益与交互体验。

如何使用GLM-4.5

- 体验平台

- 智谱清言 (chatglm.cn):可以直接访问智谱清言平台,免费体验 GLM-4.5 的满血版功能。用户可以进行对话生成、代码生成、推理任务等多种操作,感受模型的强大能力。

- Z.ai:用户也可以通过 Z.ai 平台体验 GLM-4.5 的功能。

- API 调用

- BigModel.cn:智谱 AI 提供了 API 接口,用户可以通过 BigModel平台进行 API 调用。API 接口支持多种功能,包括文本生成、代码生成、推理任务等。

GLM-4.5的模型定价

API 调用价格低至:输入 0.8 元/百万 tokens、输出 2 元/百万 tokens,生成速度最高可达 100 tokens/秒,支持低延迟和高并发部署。

GLM-4.5的应用场景

- 全栈开发任务:GLM-4.5 能胜任复杂的全栈开发任务,支持编写较为复杂的应用、游戏、交互网页等。

- 代码生成:GLM-4.5 在代码生成方面表现出色,能生成高质量的代码片段,支持多种编程语言。可以帮助开发者快速生成代码框架、修复代码错误、优化代码结构等。

- 编程辅助:模型可以作为编程辅助工具,提供代码补全、代码生成建议、代码注释等功能,提高开发效率。

- 内容生成:模型可以生成各种类型的内容,如文章、新闻报道、创意文案等,适用于内容创作、文案撰写等场景。

- 学术研究:GLM-4.5 可以用于学术研究,帮助研究人员探索自然语言处理、人工智能等领域的前沿问题。

来源:https://www.php.cn/faq/1429916.html

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- nef 格式图片降噪处理用什么工具 效果如何

- 时间:2025-07-29

-

- 邮箱长时间未登录被注销了能恢复吗?

- 时间:2025-07-29

-

- Outlook收件箱邮件不同步怎么办?

- 时间:2025-07-29

-

- 为什么客户端收邮件总是延迟?

- 时间:2025-07-29

-

- 一英寸在磁带宽度中是多少 老式设备规格

- 时间:2025-07-29

-

- 大卡和年龄的关系 不同年龄段热量需求

- 时间:2025-07-29

-

- jif 格式是 gif 的变体吗 现在还常用吗

- 时间:2025-07-29

-

- hdr 格式图片在显示器上能完全显示吗 普通显示器有局限吗

- 时间:2025-07-29

精选合集

更多大家都在玩

大家都在看

更多-

- 三角洲行动有什么载具

- 时间:2026-02-10

-

- 暖意古文网名大全男生(精选100个)

- 时间:2026-02-10

-

- 福昕PDF编辑器如何将PDF转换成PPT?福昕PDF编辑器将PDF转换成PPT教程

- 时间:2026-02-10

-

- 三角洲行动红狼榴弹炮怎么用

- 时间:2026-02-10

-

- 米哈游:终止与上海市汇业律师事务所的一切合作关系

- 时间:2026-02-10

-

- 淘宝春节领现金活动在哪里?

- 时间:2026-02-10

-

- “爱马仕橙”iPhone 17 Pro助苹果终结三年销售颓势,中国市场猛增38%

- 时间:2026-02-10

-

- 双字重复网名男生霸气(精选100个)

- 时间:2026-02-10