入选 SOSP 2025!趋境科技 KTransformers 突破异构计算瓶颈 大模型推理成本大降

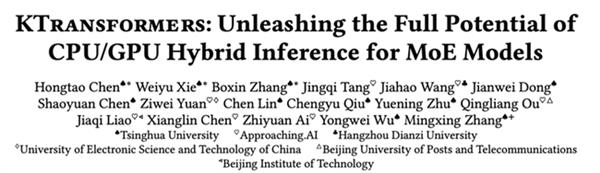

时间:2025-11-21 | 作者: | 阅读:0趋境科技与清华共同开源的高性能异构推理框架 KTransformers,其论文《KTransformers: Unleashing the Full Potential of CPU/GPU Hybrid Inference for MoE Models》成功入选 “计算机系统领域奥斯卡” SOSP 2025。作为计算机系统领域最具影响力的国际顶会之一,SOSP 见证了无数里程碑式技术成果的首次亮相,从虚拟化到分布式文件系统,此次 KTransformers 的入选,标志着其异构计算技术得到全球顶尖学术与工业界的认可。

KTransformers 专注于高效利用底层 GPU、CPU、内存等多样化算力,让大模型在更低算力、更灵活的硬件架构上高效运行。在大模型推理中,趋境科技提出了一条不同以往的道路:一套面向 CPU+GPU 异构架构的 MoE 推理系统方案,让原本只能依赖昂贵多卡 GPU 的大模型,能在 CPU 参与的硬件环境中实现接近同等性能的推理体验。技术层面上,它通过一系列系统级创新,让 GPU 负责注意力和主干网络的高并行计算,CPU 则承担稀疏专家模块的推理任务,实现了高效的 CPU+GPU 协同执行。

11 月 6 日月之暗面发布 Kimi-K2-Thinking 模型后,KTransformers 已完成对该模型的全面适配,支持用户在单卡环境下完成推理任务,2 卡环境下完成 LoRA 微调任务,大幅降低部署与定制化门槛。同时,趋境科技也已完成了该模型在昇腾 NPU 上的全面适配,提供了完善的全国产化推理解决方案。

10 月,KTransformers 与主流推理框架 SGLang 的合作,双方架构合入同一分支,在 Kimi-K2-1TB 的模型推理任务中,用户仅需简单安装 SGLang 与 KTransformers CPU 内核,下载官方模型及量化权重,即可通过一条命令启动服务;同时仅使用单张消费级 GPU+CPU。此次合作融合了 GPU+CPU 异构推理创新模式与全 GPU 的传统推理模式,双方联合推动大模型推理向更高性能、更低成本的方向演进,同时推动大模型推理架构变得更加完善,将迈向更广泛的产业落地。

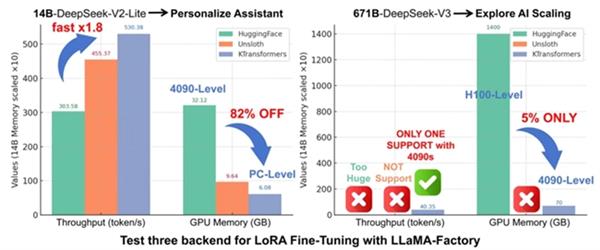

针对模型微调,KTransformers 与 LLaMA-Factory 深度集成,支持用户使用 LoRA 等轻量级微调方法,在极少量 GPU 资源下完成模型定制。传统上,LoRA 微调千亿模型成本高达数百万,趋境科技提供的异构微调能力将资源需求降低到单个消费级 GPU(如 RTX 4090)起,这使得高校、中小型实验室、初创公司甚至个人开发者都有机会参与进来。该微调方案在较小规模的 MoE 模型(DeepSeek-14B)上面也展现了超过传统方案 1.8 倍的吞吐、显存占用降低 82%,成为消费级显卡上微调超大参数 MoE 模型的唯一可行方案。

如今的 KTransformers 已成为一个被开发者、厂商与开源社区广泛复用的共建式底层框架。全球头部开源模型方,如 Qwen、Kimi、智谱 AI 等多个主流大模型,都在模型发布首日就推荐 KTransformers 作为推理引擎支持;其工程实践与兼容性也被多家一体机产品线采纳。趋境科技始终是异构路线的核心推动者,已与多个国产 CPU、GPU 硬件平台合作,共同推进全国产高性价比方案;为数十家行业开发伙伴提供算力底座,逐步实现算力普惠。未来,趋境希望让 AI 能力不再专属于少数企业,让大模型真正为业务所用。

来源:https://news.mydrivers.com/1/1087/1087912.htm

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- OPPO Reno15系列开售 影像、AI全面升级,首销福利很诱人

- 时间:2025-11-21

-

- 游戏电视迈入3.0时代 京东携手行业合作伙伴推动新标准落地

- 时间:2025-11-21

-

- 搭建高并发跨境远程控制体系 向日葵为企业提供专业方案

- 时间:2025-11-21

-

- Gartner全球大模型报告:火山引擎领跑挑战者 阿里云、腾讯云均入选

- 时间:2025-11-21

-

- 芝麻800分福利升级!firefly萤火虫7日车主权益直达 信用生活再添新玩法

- 时间:2025-11-21

-

- 绿联科技亮相2025英特尔技术创新与产业生态大会 引领AI NAS新时代

- 时间:2025-11-21

-

- 燃油车迈入智能新纪元:全新上汽奥迪A5L Sportback旗舰智曜型即将开启交付

- 时间:2025-11-21

-

- 无公网IP、跨地域访问受限 花生壳内网穿透助力CDG稳定远程访问

- 时间:2025-11-21

大家都在玩

大家都在看

更多-

- 尘白禁区噬神斗场三区域通关攻略

- 时间:2025-11-21

-

- 晋江文学城怎么调整字体大小 调整字体大小方法

- 时间:2025-11-21

-

- 荒原曙光有枪吗

- 时间:2025-11-21

-

- 饿狼传说群狼之城SCS2025第五周冠军是谁

- 时间:2025-11-21

-

- 魔兽世界军团再临remix崭新道路任务攻略

- 时间:2025-11-21

-

- 魔兽世界军团再临remix流明石任务攻略

- 时间:2025-11-21

-

- 魔兽世界军团再临remix黑暗曙光任务攻略

- 时间:2025-11-21

-

- 2025年必玩MOD游戏推荐及功能菜单全解析

- 时间:2025-11-21