NVIDIA要用上X3D堆叠设计!下代Feynman GPU将引入LPU

时间:2025-12-29 | 作者: | 阅读:012月29日消息,虽然NVIDIA目前在AI训练领域无可匹敌,但面对日益增长的即时推理需求,其正筹划一项足以改变行业格局的“秘密武器”。

据AGF透露,NVIDIA计划在2028年推出的Feynman(费曼)架构GPU中,整合来自Groq公司的LPU(语言处理单元),以大幅提升AI推理性能。

Feynman架构将接替Rubin架构,采用台积电最先进的A16(1.6nm)制程,为了突破半导体物理限制,NVIDIA计划利用台积电的SoIC混合键合技术,将专为推理加速设计的LPU单元直接堆叠在GPU之上。

这种设计类似于AMD的3D V-Cache技术,但NVIDIA堆叠的不是普通缓存,而是专为推理加速设计的LPU单元。

设计的核心逻辑在于解决SRAM的微缩困境,在1.6nm这种极致工艺下,直接在主芯片集成大量SRAM成本极高且占用空间。

通过堆叠技术,NVIDIA可以将运算核心留在主芯片,而将需要大量面积的SRAM独立成另一层芯片堆叠上去。

台积电的A16制程一大特色是支持背面供电技术,这项技术可以腾出芯片正面的空间,专供垂直信号连接,确保堆叠的LPU能以极低功耗进行高速数据交换。

结合LPU的“确定性”执行逻辑,未来的NVIDIA GPU在处理即时AI响应(如语音对话、实时翻译)时,速度将实现质的飞跃。

不过这也存在两大潜在挑战,分别是散热问题和CUDA兼容性难题,在运算密度极高的GPU 再加盖一层芯片,如何避免“热当机”是工程团队的头号难题。

同时LPU强调“确定性”执行顺序,需要精确的内存配置,而CUDA生态则是基于硬件抽象化设计的,要让这两者完美协同,需要顶级的软件优化。

来源:https://news.mydrivers.com/1/1095/1095424.htm

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- 国产GPU重磅发布 明年超英伟达Rubin架构:中国院士力挺天数智芯

- 时间:2026-01-27

-

- 国产GPU四小龙之一 燧原科技IPO获受理

- 时间:2026-01-22

-

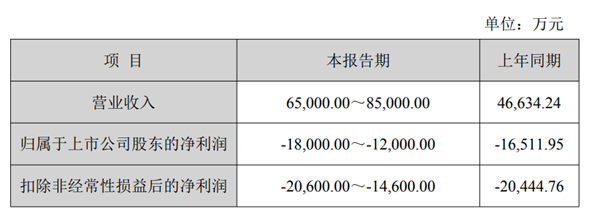

- 国产GPU公司景嘉微去年亏了1.2-1.8亿:自研GPU可满足云桌面、云游戏等应用

- 时间:2026-01-15

-

- 英伟达官宣新一代GPU 推理算力是Blackwell的5倍

- 时间:2026-01-06

-

- 中国四大GPU公司都完成IPO 围堵英伟达!壁仞科技今日上市 股价涨幅最高超100%

- 时间:2026-01-02

-

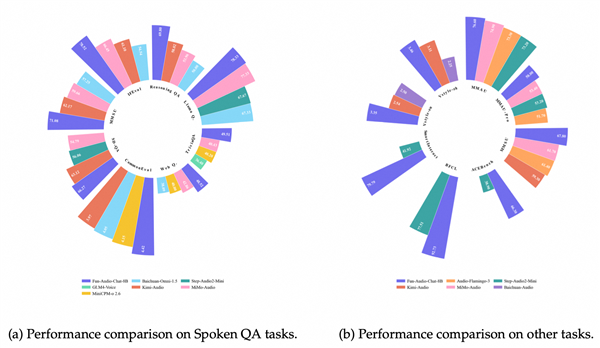

- 节省近50%GPU计算!通义百聆开源新一代语音交互模型

- 时间:2025-12-24

-

- 市值2800亿!摩尔线程后 又一国产GPU公司上市:股价暴涨568% 中一签可赚30万元

- 时间:2025-12-17

-

- 国产NVIDIA之后国产AMD也来了 沐曦中签率公布:比摩尔线程难抢

- 时间:2025-12-08

精选合集

更多大家都在玩

大家都在看

更多-

- 虚拟三字网名男生霸气(精选100个)

- 时间:2026-02-16

-

- 音游难民是什么意思

- 时间:2026-02-16

-

- 跳票是什么意思

- 时间:2026-02-16

-

- 逆战朱雀换购流程是什么

- 时间:2026-02-16

-

- 男生网名00后文艺(精选100个)

- 时间:2026-02-16

-

- 社会摇是什么意思

- 时间:2026-02-16

-

- 肝稿是什么意思

- 时间:2026-02-16

-

- 冷门有趣网名男生二字(精选100个)

- 时间:2026-02-16