ollama怎么启动deepseek

时间:2026-02-05 | 作者: | 阅读:0一、Ollama 安装与环境配置

用户需从 Ollama 官方网站下载对应操作系统的二进制安装包。Windows 用户可通过修改系统环境变量设置模型存储路径,Linux/macOS 用户则编辑.bashrc或.zshrc文件,添加export OLLAMA_HOME="/自定义路径"。需注意,Ollama 不支持 pip 安装,推荐直接使用官方安装包。安装完成后,通过命令行输入ollama version验证安装状态。

二、模型下载与硬件要求

启动模型前需确保设备满足最低配置:16GB 内存 + 8GB 显存(推荐 32GB 内存 + 16GB 显存)。使用 Ollama 命令行工具直接运行模型下载与启动:

bash

ollama run deepseek-r1:7b

该命令会自动下载 7B 版本的 DeepSeek 模型并启动服务。若需其他版本,可通过ollama list查看可用模型。模型文件默认存储于~/.ollama/models目录,可通过环境变量自定义存储路径。

三、模型交互与服务验证

模型启动后进入交互模式,用户可直接输入问题与模型对话。输入/help查看可用指令,输入exit退出交互。系统将自动检测 GPU 并启用加速,可通过日志确认是否成功调用 GPU 资源。此外,Ollama 提供 HTTP API 接口,示例调用方式如下:

bash

curl -X POST http://localhost:11434/api/generate

-H "Content-Type: application/json"

-d '{"model": "deepseek-r1:7b", "prompt": "你好"}'

四、高级配置与注意事项

如需自定义服务参数,可通过ollama serve --listen localhost:11435指定监听地址和端口。部署前需确保硬件配置达标,低配置设备可能导致运行卡顿或内存溢出。若遇模型加载失败,可尝试删除~/.ollama/models目录后重新下载。

来源:https://g.pconline.com.cn/x/1901/19014405.html

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- 北方抢黄桃罐头南方抢醋

- 时间:2026-02-06

-

- 在美课堂APP里清理缓存的具体方法

- 时间:2026-02-06

-

- 多多进宝怎么推广赚佣金

- 时间:2026-02-06

-

- 钟南山:第二波奥密克戎患病率更高

- 时间:2026-02-06

-

- 雪狐狸APP注册账号的方法分享

- 时间:2026-02-06

-

- 钟南山提出8条个人防护建议

- 时间:2026-02-06

-

- 在诗歌本中分享诗歌的方法介绍

- 时间:2026-02-06

-

- 中国人寿客服回应新冠阳性不理赔

- 时间:2026-02-06

精选合集

更多大家都在玩

大家都在看

更多-

- 武松第40集剧情介绍

- 时间:2026-02-06

-

- 奥星热浪何时能下载

- 时间:2026-02-06

-

- 云之国绿原黑暗池塘洞穴宝箱怎么解谜

- 时间:2026-02-06

-

- 金的谐音梗网名男生(精选100个)

- 时间:2026-02-06

-

- 鲑鱼之乱是什么意思

- 时间:2026-02-06

-

- 星际战甲什么甲清图快

- 时间:2026-02-06

-

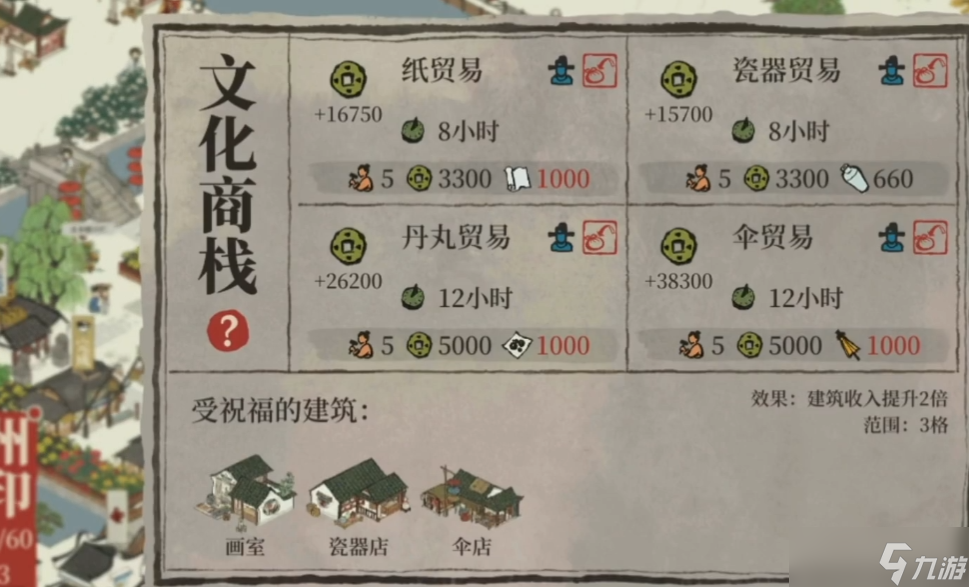

- 江南百景图的商栈怎么建

- 时间:2026-02-06

-

- 在蓉e行中查看违章图片的方法分享

- 时间:2026-02-06