如何用豆包AI学习大数据分析?Hadoop与Spark入门

时间:2025-06-28 | 作者: | 阅读:0豆包ai可作为学习hadoop和spark的辅助工具,通过以下方式帮助新手入门:1. 解释核心概念并结合用户背景举例说明,如用java或python视角解释rdd;2. 生成示例代码并协助调试,如编写pyspark的wordcount程序并分析错误原因;3. 模拟真实场景练习,引导完成数据清洗、统计、导出等流程;4. 提供技术选型建议,如对比spark streaming与flink、hive与spark sql。

如果你对大数据分析感兴趣,又刚好在用豆包AI(Doubao),那其实可以把它当作一个学习助手来辅助你掌握Hadoop和Spark的基础知识。虽然豆包AI本身不是数据分析工具,但它能帮你理解概念、写代码、查错、甚至模拟练习,关键在于你怎么用。

下面是一些实际的使用方法,适合刚开始接触Hadoop和Spark的新手。

1. 用豆包AI快速理解Hadoop与Spark的核心概念

刚开始学的时候,最容易被各种术语绕晕,比如MapReduce、HDFS、RDD、DataFrame、YARN这些词。你可以直接问豆包AI:“Hadoop和Spark有什么区别?”、“什么是RDD?”、“HDFS是怎么工作的?”

立即进入“豆包AI人工智官网入口”;

立即学习“豆包AI人工智能在线问答入口”;

它会用通俗的语言解释清楚,并且还能结合你的背景调整回答方式。比如你是Java程序员转行,它可能会用类比的方式说明RDD和Java集合的区别;如果你是Python用户,它也能从PySpark的角度讲。

建议:

- 遇到不懂的术语先问一遍

- 让它举简单的例子帮助理解抽象概念

- 可以让它画个流程图或结构图(虽然不能真画出来,但文字描述也能帮理清逻辑)

2. 让豆包AI帮你写和改基础代码

不管是Hadoop的MapReduce程序,还是Spark的Scala/Python脚本,很多新手一开始都不知道怎么下手。这时候可以直接让豆包AI生成一段示例代码,比如:

“帮我写一个WordCount的Spark程序,用Python。”

然后你就能看到一段PySpark的代码,并了解每一步的作用。如果运行出错了,也可以把错误信息贴给它看,它会帮你分析问题在哪。

常见问题处理建议:

- 环境配置问题(如找不到spark-submit)

- 数据读取路径不对

- RDD转换操作没触发执行(没有调用action算子)

- 分区数设置不合理导致性能差

3. 用豆包AI模拟真实场景进行练习

你可以假设一个实际场景,比如“我要分析电商网站的用户点击日志”,然后让豆包AI一步步引导你完成数据清洗、统计、聚合等步骤。它会告诉你该用什么组件、怎么组织代码结构、如何优化性能。

比如你可以这样提问:

- “我有一个CSV文件,里面有用户的访问记录,怎么用Spark计算每个用户的访问次数?”

- “怎么把Hadoop的数据导出成Parquet格式?”

这种模拟练习虽然不能替代真实环境,但能让你更快上手,避免一开始就卡在细节里。

4. 用豆包AI查文档和对比技术选型

Hadoop和Spark生态有很多模块,比如Hive、Presto、Flink、Kafka等。刚开始可能不知道哪些是必须学的,哪些可以后面再补。你可以问豆包AI:

- “我现在想做实时数据分析,应该学Spark Streaming还是Flink?”

- “Hive和Spark SQL哪个更适合入门?”

它会根据当前主流做法、社区活跃度、学习曲线等角度给出建议,帮你少走弯路。

基本上就这些。豆包AI不是万能的,但在学习初期,它可以当一个随时在线的“学习伙伴”。只要你有问题就去问,多试几次就会发现它的节奏和你能配合上。关键是别怕问“小白问题”,它不会嫌你烦。

来源:https://www.php.cn/faq/1377996.html

免责声明:文中图文均来自网络,如有侵权请联系删除,心愿游戏发布此文仅为传递信息,不代表心愿游戏认同其观点或证实其描述。

相关文章

更多-

- vivo、联想等多家硬件厂商入局:字节豆包AI手机合作版图曝光

- 时间:2025-12-19

-

- 联想与字节豆包AI手机合作引关注 内部人士披露更多关键业务

- 时间:2025-12-19

-

- 抖音App测试接入豆包AI能力已开放两个入口

- 时间:2025-11-28

-

- ai生成视频入口

- 时间:2025-10-21

-

- ai生成图片在线制作

- 时间:2025-10-21

-

- 豆包AI智能体怎么生成

- 时间:2025-09-08

-

- 豆包AI云盘文件上传全流程教学

- 时间:2025-09-08

-

- 如何用豆包AI撰写创投BP大纲 豆包AI商业计划书模板生成

- 时间:2025-07-29

精选合集

更多大家都在玩

热门话题

大家都在看

更多-

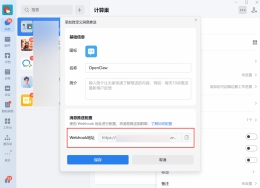

- 电脑小白怎么安装OpenClaw?官方一键安装(推荐新手)

- 时间:2026-03-10

-

- Windows电脑怎么使用OpenClaw官方安装脚本(一键安装)?

- 时间:2026-03-10

-

- 是否支持从自定义文件夹加载 Skills?OpenClaw中Skills加载的优先级是什么?

- 时间:2026-03-10

-

- 如何在OpenClaw中安装或添加Skills?

- 时间:2026-03-10

-

- 如何更改OpenClaw调用的模型?

- 时间:2026-03-10

-

- 如何查看OpenClaw的端口号?

- 时间:2026-03-10

-

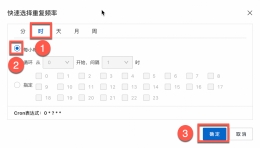

- openclaw如何使用AppFlow为企业微信配置定时任务?

- 时间:2026-03-10

-

- openclaw如何使用AppFlow为飞书配置定时任务?

- 时间:2026-03-10